[STRUCE1] Gradivo

koBASA

Stark

w2 bi ti bilo -1*0*3 + (-1)*0.01*4 + 1*0.01*4 pa je to nula, nema to veze s tim da je prvi član vektora alfa 0, to ti samo znači da ne gledaš vektor koji nije potporni jer ga 0 poništi.

Ziher

hi_doggy Znaci imamo 2 slucaja: alpha je 0 (promatrani vektor nije potporni) i alpha >0 (promatrani vektor je potporni), sto znaci da izraz u drugoj zagradi mora biti jednak 0 da bi jednakost vrijedila. Taj drugi izraz znaci da se promatrani vektor nalazi na margini (ksi je 0) ili unutar nje (ksi je veci od 0). S obzirom kako ksi ne moze biti < 0, potporni vektori nikad nece izaci izvan margine s prave strane granice.

Sto se tice drugog pitanja, zapises si tu razliku u odnosu na rijec “straja” i onda gledas koji su ti primjeri najblizi (konkretno, 3 clana za koji imas najmanji L) i onda ih prebrojis i napravis glasanje (2 jedinice + 1 nula = klasa 1). Onda, samo sto trebas je uvrstiti to sto si dobio u ovu jezgru i gledas najvece brojeve koje si dobio (jer je slicnost veca) i opet dobijes 1. Znaci h1=h2=1

Stark

Dima Za ovaj primjer gdje je vrijednost -1 (na prvoj slici na kraju) mi ispada w0 = -59.73. Što radim krivo? Ne bi se smjelo dogoditi da w0 ima dvije različite vrijednosti, zar ne?

carrieb

Stark u skripti pise da bi se ovo trebalo napraviti, makar je i meni cudno da je toliko velika razlika ako uzmemo jedan ili drugi primjer… sa srednjom vrijednosti w0 ne dolazi dobro rjesenje na pitanju

Bananaking

Ovo se čini kao relativno jednostavan zadatak ali sam loš i ne kužim baš to preslikavanje pa jel bi mogao netko šerati svoj postupak?

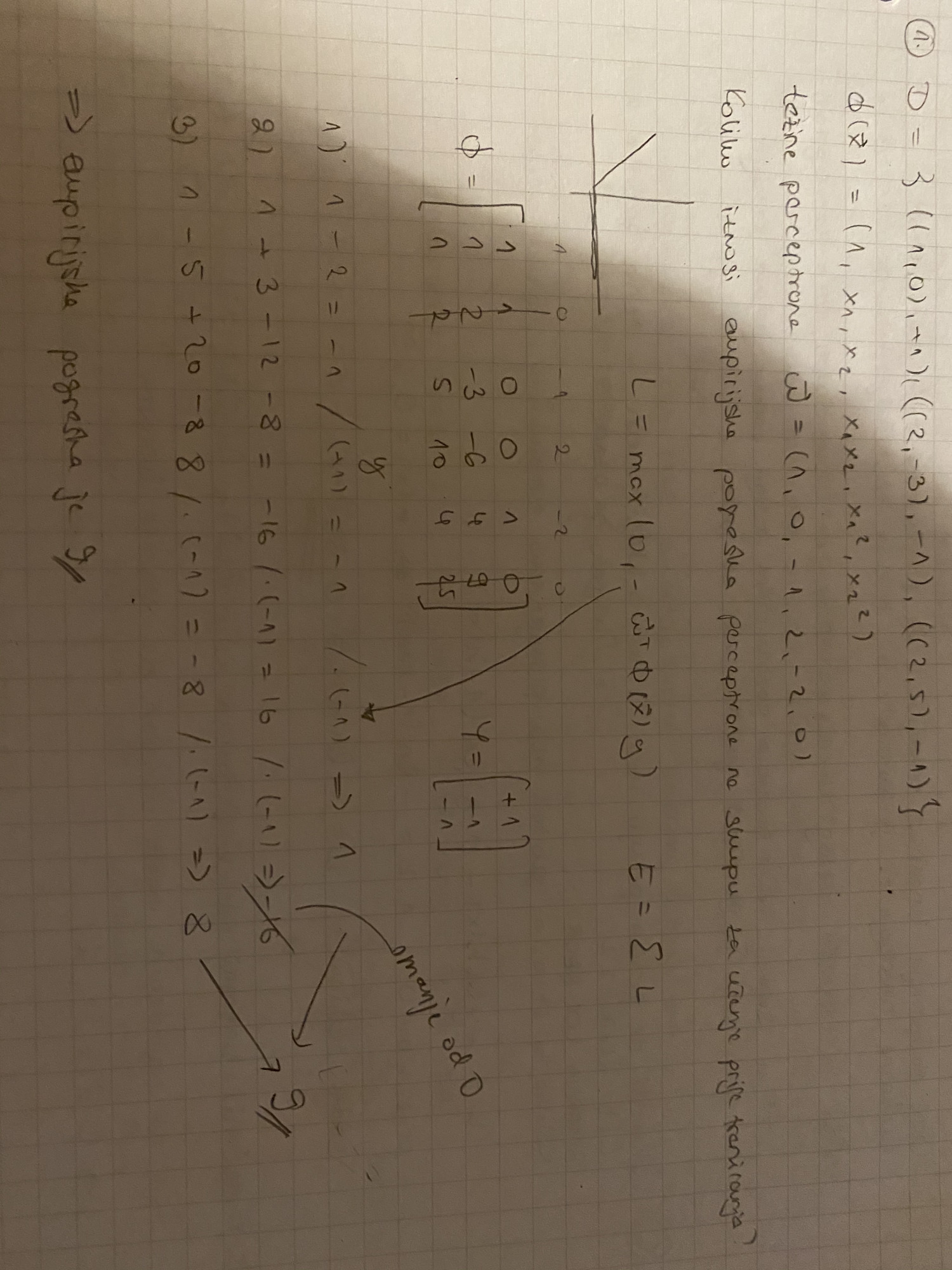

Pretpostavljam da se treba samo računati empirijska greška po formuli iz skripte kao sumu od i do N funkcije max(0, -wT preslikano(xi) yi

ImJustAKid

Stark

Može objašnjenje?

cotfuse

Stark taj jedan hiperparametar je \sigma, koji je dijeljen izmedju svih kernela, 1001 parametar su parametri odabira znacajki u rijetkom jezgrenom stroju, 2829 parametara su 28*100 sto oznacava znacajke odabranih prototipa, + 28 znacajki znacajnosti tih prototipa, to je znaci 28 od ovih 1001 koje optimiziras, znaci koliko svaki od njih pridonosi konacnom rezultatu i jedan je bias

Atem

Ako bi netko mogao objasniti ova tri ili barem reći koje je točno

Amali

- 1. ENm

- E za svaku epohu. U svakoj epohi prodjes po svakom primjeru da bi azurirao tezine, dakle *N. Za svaki primjer prodjes po svakoj znacajki , dakle *m.

- 2. fi(x) = (1, x)

- granica nam treba biti linearna u ulaznom prostoru. Narav funkcije f nam nije bitna za izgled granice, bitne su samo znacajke, dakle preslikavanje mora biti linearno, jer ako je preslikavanje nelinearno imas linearnu granicu u tom visem prostoru, a kad se vratis u ulazni dobijes nelinearnu granicu.

- 3. funkciju gubitka i optimizacijski postupak

- kada promijenis funkciju gubitka s ovog sto je, moras i promijeniti optimizacijski postupak da pase za tu funkciju gubitka koju si odabrao, postupak najmanjih kvadrata je sam za kvadratni gubitak

sphera

ima netko ovaj postupak

Amali

sphera

Prvo izracunas tezine jer ti ionak trebaju za regulariziranu gresku. To mozes napravit matricno - vektor alpha, svaki alpha pomnozen oznakom y pripadnog vektora, puta matrica dizajna (jedan redak jedan primjer). To su ti tezine

Onda imas funkciju pogreske koja je suma gubitaka + regularizacijski faktor, a to je 1/2C * norma tezina na kvadrat (C je 1/lambda). Ovdje pazis da ne ukljucujes tezinu w0 u normu tezina jer se ona ne regularizira, dakle sam ono kaj daje matricno mnozenje ubacis u formulu za normu vektora i kvadriras (ili ni ne korjenujes in the first place, suma kvadrata elemenata, skalarni produkt)

Za gubitak u pogresci (ovo u sumi) ti treba h(x) za svaki vektor, i to mozes izracunat na primarni il dualni nacin sam po formulama i uvrstis u pogresku.

johndoe12

Amajli

tezine su mi w1=-0.09, w2=-0.08, w3=0.05

h(x1) i h(x2) su mi -1, znaci njihov loss je 0, dakle u empirijskoj pogeski imam samo x3

h(x3) dobijem -0.87

(1-h(x3)) = 1.87

i kad sve to uvrstim u E, dobijem gresku 2.72.

Gdje grijesim?

Amali

enaiks ja tezine dobijem 0.02, 0, -0.03, tak da tu nesto. Mnozenje s oznakom y (alpha bude [0, -0.01, 0.01] s tim y ukljucenim) mislim da je, iako bi w1 bio -0.06 tako, a i msm da bi w2 bio pozitivan

buduci da je prvi 0, mozes i smanjit izracun, pa imas alpha*y onda = [-0.01, 0.01], a matrica s kojom mnozis je [[-4, 4, 4],[-2, 4, 1]]

Amon

Amajli

Kolega je gore riješio taj zadatak

https://fer.studosi.net/d/1348-struce-pitanja-i-odgovori/95

Bananaking

Ovaj još nisam vidio ako se ne varam, može netko opisati rješavanje?

Amali

Bananaking ima par rasprava o ovom ako se ne varam

Amon

Bananaking Cetvrti zadatak:

adaptivne bazne funkcije == neuronska mreza s jednim skrivenim slojem. ulazni parametri imaju 10 varijabli, svaka adaptivna bazna funkcij ima dakle 10 tezina + 1 bias. Takvih adaptvnih baznih funkcija ima 4, dakle sve skupa 4(10+1) = 44. Zavrsili smo prvi sloj, ai time smo samo iz podataka izvadili znacajke, sto znaci da tek sad idemo u softmax. Znaci sad se pravimo da su ovih 4 “pravi podaci”, dakle trebat ce nam jos 4 tezine i 1 bias. Sve skupa 44+5=49. Puno je lakse ako gledas slikicu i pratis sta se dogada nego ovak napamet rjesavat

copy-pasted from @InCogNiTo124

johndoe12

dammitimmad Je li netko zna ovaj? Meni se cini da je a, al nisam garant..