[STRUCE1] Gradivo

Amariska

Prosjek ocjena se treba izbaciti jer je kombinacija prve četiri značajke.

linearne: x1, x2, x3, x4, x6, x7

kvadratne: x12, x22….

interakcijske: parova ima 6C2 = 15, trojki ima 6C3 = 20

6 + 6 + 15 + 20 + dummy = 48

Rang matrice mora biti m+1=48, pa treba biti minimalno 48 primjera jer da ih je manje i rang bi bio manji, tj. bio bi max N

Banananjeros

Može li neko objasnit ovaj?Zašto je A točno i zašto regresija nema ovaj problem, a perceptron ima?

SuperSjajan3

tomekbeli420

Banananjeros zato što algoritam perceptrona se zaustavlja tek onda kad su svi primjeri ispravno klasificirani, dok gradijentni spust kod logističke regresije se zaustavlja kad se dosegne minimum funkcije pogreške (globalni, jer je konveksna), koji može biti koliki god (nikad 0 tho), pa makar i relativno visok zbog linearne neodvojivosti. To će se uvijek desiti ako se koristi linijsko pretraživanje

BillIK

netko_tamo možeš slikati postupak ako si riješio?

SuperSjajan3

BillIK malo je neuredno, puno brisanja je bilo, reci ak nesto ne vidis procitat

SuperSjajan3

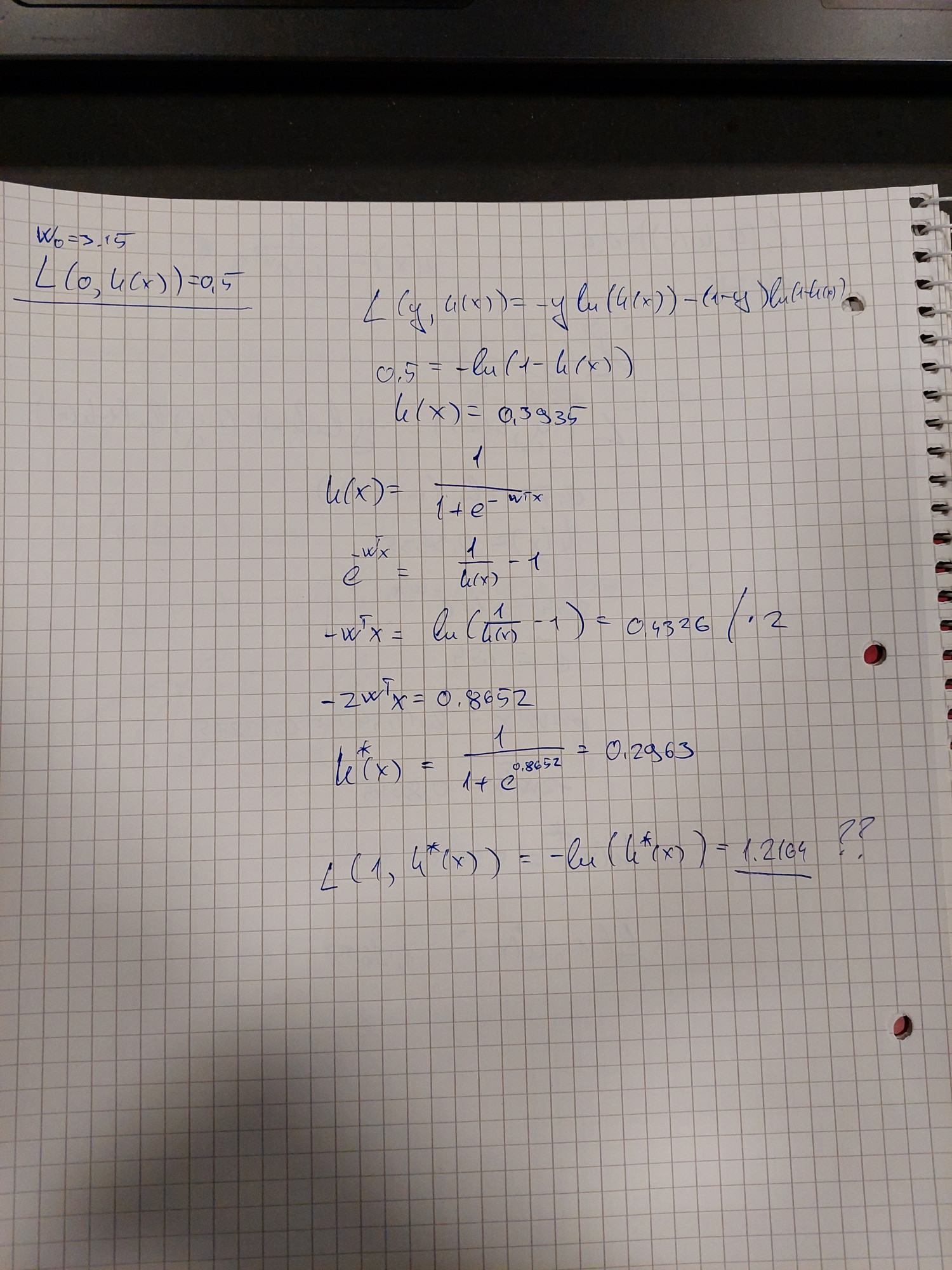

Moze pomoc oko ovog zadatka pls. Raspisem L tako da dobijem h(x), al onda ne znam sta bi dalje s tim

BillIK

SuperSjajan3 h(x) je sigmoidalna funkcija od umnoška težina i primjera + w0. Izračunaj umnožaš wT*X i koristi za računanje novog gubitka, ali pomnoženo s 2 jer ti kaže da se značajke množe s dva i s promijenjenom oznakom

gad_gadski

BillIK

Meni uporno 1.2164 ispada, je li samo treba ovaj umnozak w*x pomnoziti s dva ili? Nez di mi je greska

lovro

Jel ima neki jednostavan način za downgrade matplotlib-a bez da ga deinstaliravam pa instaliravam stariju verziju?

-Ivan-

viliml

Kako si došao do ove prve dvije formule?

viliml

Ivančica Prvo je gubitak primjera x s oznakom 0, drugo je gubitak primjera 2x s oznakom 1. Samo sam odmah izbacio onaj dio koji se množi s 0 u općenitoj formuli, ionako je to zapravo samo te dvije formule prisilno spojene množenjem s 0/1.

steker

Zasto D nije tocan

tomekbeli420

steker Neka je zadana sljedeća situacija:

Neka je \mathcal{X} = \mathbb{R}, odnosno n = 1, i naravno \mathcal{Y} = \left\{-1, +1\right\}, te neka je skup primjera za učenje

\mathcal{D} = \left\{\left( x^{(i)}, y^{(i)} \right)\right\} = \left\{\left(2, -1\right), \left(6, +1\right)\right\}

Jasno je da su primjeri linearno odvojivi.

Odgovor D implicira da postoji mogućnost da će SVM izabrati ovakvu hipotezu

h \left(x ; w_1, w_0\right) = x - 5

odnosno da je w_1 = 1 i w_0 = -5

što bi značilo da je granica x = 5

problem je kod ovog “… za najbliže primjere” jer se tu nigdje ne spominje da SVM udaljenost najbližih primjera mora maksimizirati, pa je prema tom odgovoru moguće da mu je najbliži samo jedan primjer (u našem primjeru ova šestica), i za taj primjer da vrijedi y h(x) = 1. To naravno kod pravog SVM-a nije istina, jer on maksimizira minimalnu udaljenost, i to je sve ukodirano sa onim problemom minimizacije kvadrata vektora težina uz ograničenja da hipoteze moraju dati iznose apsolutno veće od 1.

cloudies

gad_gadski Koliko mi se cini, ti si pomnozio sve s 2, a tamo ti se nalazi i dummy jedinica koju si pretvorio u dvojku. Msm da trebas razdvojit na w i w0.

Amariska

BillIK

gad_gadski ovo što je kolega cloudies napisao

Banananjeros

Jasno mi je zašto A i B neće konvergirati, ali koja je razlika između C i D? Zašto logistička regresija s linearno odvojivim PHI1 preslikavanjem neće konvergirati?

sheriffHorsey

Banananjeros pa upravo je poanta u tome sto imas linearno odvojiv slucaj, algoritam ce povecavati tezine, ako tezine rastu onda raste i vrijednost umnoska \mathbf{w}^T \phi(\mathbf{x}), a ako to raste onda sigmoida uvijek moze biti sve strmija i liciti sve vise na funkciju praga pa onda uvijek mozes smanjiti gubitak, a u d slucaju posto nemas linearnu odvojivost nemas taj problem i u jednom trenu neces vise moc smanjiti gubitak pa dolazi do konvergencije

viliml

Banananjeros Krivo je zadan zadatak jer empirijska pogreška uistinu konvergira i sa linearno odvojivim skupom podataka, stvar je da pritom težine divergiraju.

prx_xD

Ima netko možda ss od prošlogodišnjih moodle kvizova

steker

Koja bi bila pristranost preferencijom kod perceptrona? Jel bi to zapravo bila linearna odvojivost podataka ili to nema veze s pristranoscu

steker

steker ne znam jel ovo glupo razmisljanje, ali takoder jel se moze rec da su pristranosti jezikom kod SVM-a i perceptrona iste s obzirom da svm u primarnom obliku ima za h(x)=sgn(wtx), a perceptron h(x)=step(wtx), (znam da su step i sgn dvije razlicite func ali obje onako kako smo ih definirali na predavanjima bacaju van -1 tj1 za iste vrijednosti x)

viliml

steker Perceptron nema nikakvu pristranost preferencijom. Svaka hipoteza koja ispravno klasificira skup za treniranje je njemu jednako dobra. To je jedan od mnogih razloga zašto je to loš algoritam.

steker Pristranost jezikom je praktički ista stvar što i model. SVM i perceptron oboje koriste linearni model, dakle da.