[STRUCE1] Gradivo

viliml

Rene Da sori išao sam napamet i zbunio sam se, znao sam da je tako nešto otprilike.

tomekbeli420 Hoćeš reći da prostor hipoteza obuhvaća sve krivulje drugog reda? To je validno, ali treba obrazložiti zašto postoji krivulja drugog reda koja odvaja XOR, što je ekvivalentno originalnom problemu osim ako se to smatra opće poznatim…

Ali u svakom slučaju za drugu jezgru se mora naći ručno (hipoteza je isto krivulja drugog reda ali nije općenita), a pošto su za binarne značaje x i x^2 ista stvar, vidi se da je rješenje za jedno ujedno i rješenje za drugu.

tomekbeli420

viliml da to sam mislio

Zašto postoji krivulja? Vizualno je trivijalno konstruirati primjer takve krivulje xD

Da mi se da zajebavati sa rotacijama čak bi i složio težine koje čine elipsu oko pozitivnih primjera, al mi se ne da (a i može se napamet nešto nabosti)

Rene

viliml otkud ti da je w0 otprilike 0.95?

viliml

Rene hipoteze potpornih vektora moraju biti +-1

netko_tamo

moze neko objasniti? koristimo 50 znacajki ak sam dobro pobrojao

Fica

netko_tamo Izbacuješ prosjek ocjena jer ti je savršeno koreliran sa prosjecima svake godine i onda imaš 6 linearnih i 6 kvadratnih + 1 i još za interakcijske imaš 6 povrh 2 = 15 i 6 povrh 3 = 20 i onda ispadne 6+6+1+15+20=48

netko_tamo

Prof tenks 😃

netko_tamo

L2 norma je sqrt(wTw), dobivam 2.96, ocito nekaj kardinalno krivo radim pa ne vidim hahah

viliml

netko_tamo Norma gradijenta gubitka, ne norma težina.

Hipoteza je mrvicu veća od 0 dakle greška je mrvicu manja od 1 dakle gradijent je mrvicu manji od vektora značajki koji ima normu 2.5

BillIK

netko_tamo možeš slikati postupak ako si riješio?

Rene

viliml ne moraju ako je rijec o mekoj margini?

viliml

Rene Nigdje ne piše da je meka.

Banananjeros

Može li neko dati neki hack kako razlikovati induktivnu pristranost jezikom od induktivne pristranosti preferencijom?

bodilyfluids

Pristranosti jezikom biras model, dakle skup svih hipoteza koje dolaze u obzir. Iz tog skupa moraš nekako odabrati jednu hipotezu. To činiš funkcijom pogreške, i to je upravo pristranost preferencijom. Dodatno, ako prostor inačica ima više hipoteza (2, 3, inf), opet moraš izabrati jednu, (kod SVM-a recimo onu s najvecom marginom), to je isto pristranost preferencijom.

Prostor inačica je skup svih hipoteza nekog modela koje ispravno klasificiraju (tj predviđaju kod regresije) sve primjere.

Banananjeros

Dragi prijatelj strojnog učenja Je li pristranost preference isključivo traženje neke hipoteze u prostoru inačica ili traženje neke hipoteze u prostoru hipoteza općenito?

viliml

Banananjeros Po definiciji to bi trebalo biti u prostoru inačica, ALI…

Mi zapravo skoro nikad ne radimo baš s prostorom inačica.

Često je ili prostor inačica prazan, ili mi možda odaberemo hipotezu izvan prostora inačica jer ona bolje generalizira.

Prisutnost šuma i mogućnosti krivo klasificiranih primjera za treniranje čine koncept prostora inačica besmislenim.

Jedini slučaj kad uistinu radimo direktno s prostorom inačica je SVM s tvrdom marginom.

Ali funkciju pogreške ipak često neprecizno nazivaju pristranost preferencije, i ako dođe takvo pitanje u ispitu trebao bi ne razmišljati preduboko o tome jer oni sigurno nisu.

gladiator

Imam pitanje za težinski k-NN. Zašto gledamo sve primjere (i za sve primjere računamo k(x_i, x)) kad koristimo k-NN.

Tu gubimo “k” iz k-NN. Zar ne bi smo trebali gledati najbliže primjere i onda na temelju njih i rezultatata funkcije k(x_i, x) zaključiti kojoj klasi pripada x?

Rene

gladiator mislim da se moze i jedno i drugo, na predavanju je snajder napisao da se uobicajeno koristi N ali da suma moze ic i samo za k najblizih

gad_gadski

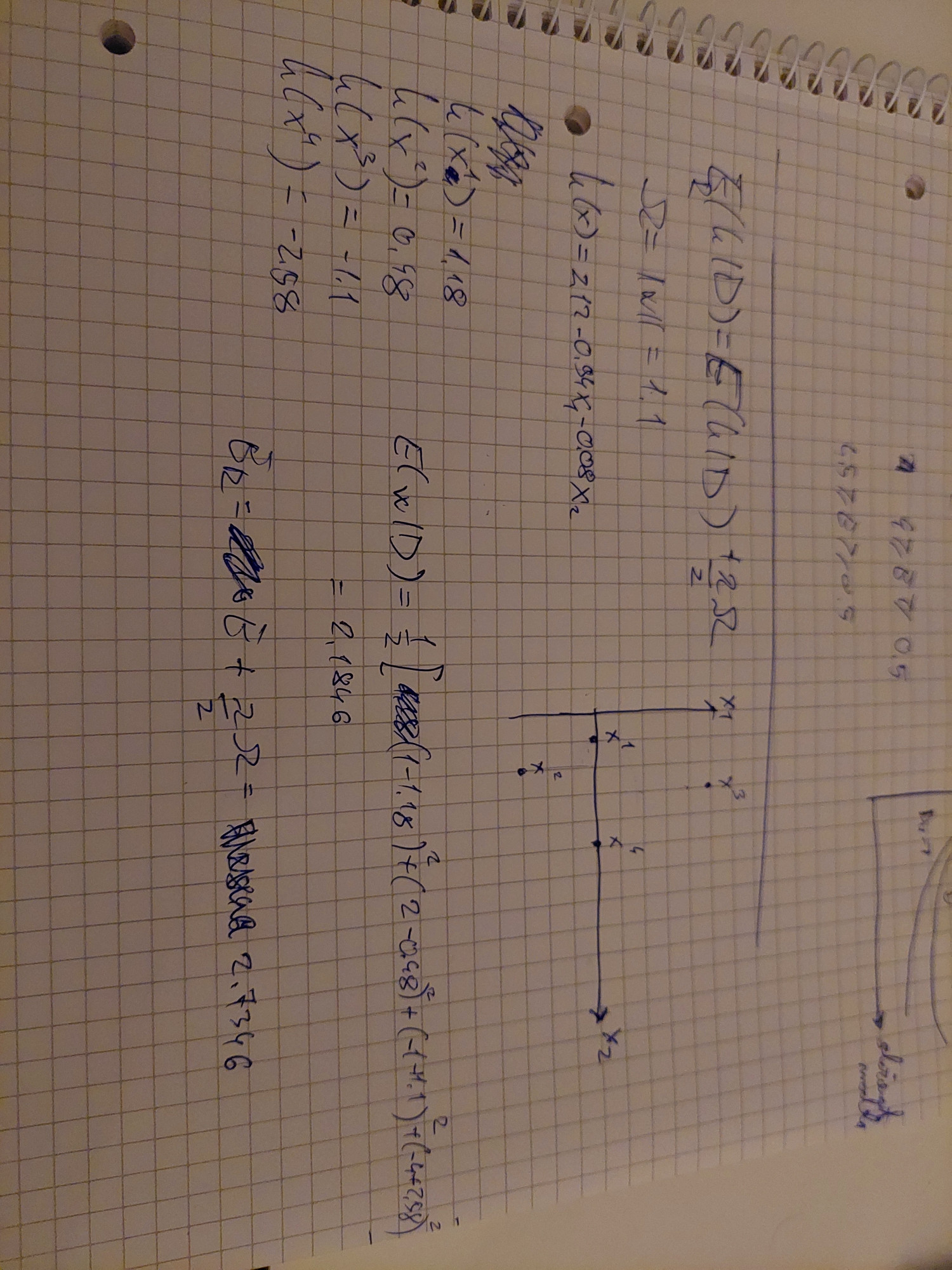

Jel zna netko kako oni dobiju 2.69? Meni ispada 2.7346, kvadratna pogreska mi ispadne 2.1846 i onda to zbrojeno s ½ * 1.1 = 2.7346

Amariska

Kad se računa L1-norma uzimaju se apsolutne vrijednosti i to bez težine w0, pa imaš 0.94+0.08 = 1.02

2.1846 + 1.02/2 = 2.69

BillIK

zna netko ovaj zadatak?

Amariska

Prosjek ocjena se treba izbaciti jer je kombinacija prve četiri značajke.

linearne: x1, x2, x3, x4, x6, x7

kvadratne: x12, x22….

interakcijske: parova ima 6C2 = 15, trojki ima 6C3 = 20

6 + 6 + 15 + 20 + dummy = 48

Rang matrice mora biti m+1=48, pa treba biti minimalno 48 primjera jer da ih je manje i rang bi bio manji, tj. bio bi max N