[STRUCE1] Gradivo

steker

steker ne znam jel ovo glupo razmisljanje, ali takoder jel se moze rec da su pristranosti jezikom kod SVM-a i perceptrona iste s obzirom da svm u primarnom obliku ima za h(x)=sgn(wtx), a perceptron h(x)=step(wtx), (znam da su step i sgn dvije razlicite func ali obje onako kako smo ih definirali na predavanjima bacaju van -1 tj1 za iste vrijednosti x)

viliml

steker Perceptron nema nikakvu pristranost preferencijom. Svaka hipoteza koja ispravno klasificira skup za treniranje je njemu jednako dobra. To je jedan od mnogih razloga zašto je to loš algoritam.

steker Pristranost jezikom je praktički ista stvar što i model. SVM i perceptron oboje koriste linearni model, dakle da.

viliml

Ivančica Prvo je gubitak primjera x s oznakom 0, drugo je gubitak primjera 2x s oznakom 1. Samo sam odmah izbacio onaj dio koji se množi s 0 u općenitoj formuli, ionako je to zapravo samo te dvije formule prisilno spojene množenjem s 0/1.

viliml

viliml Zapravo možeš proći kroz cijeli izvod u poglavlju 2.1 skripte broj 6, preskočiti ono kad zamjene if/else sa potenciranjem i množenjem i izvesti funkciju gubitka

L(y,h(\mathbf{x}))=\begin{cases} -\ln h(\mathbf{x}) & \text{ako }y=1 \\ -\ln (1-h(\mathbf{x})) & \text{inače} \end{cases}

Iskreno ne znam zašto su uopće radili te gluposti, ovaj oblik je puno jasniji.

steker

viliml

A onda ne razumijem zasto bi ovo pod B bilo krivo, osim ako je problem u prvom navodu

bodilyfluids

Mooooožda se može reći da perceptron “preferira” onu hipotezu do koje ga slučajno odvede gradijentni spust?

Tako sam i ja shvatio. Pristranost preferencijom (PP) je cijeli optimizacijski postupak, uključujući fju pogreške i algoritam (npr. gradijentni spust). PP perceptrona je uzimanje hipoteze u kojoj gradijentni spust konvergira. Po toj logici onda PP modificiraš hiperparametrom stope učenja.

Al idk, možda samo filozofiram i stvarno je greška u zadatku 😅

viliml

steker Rekao bih da je to samo krivo zadan zadatak. Nije ni prvi ni zadnji put.

Možda općenito zovu funkciju pogreške pristranosti preferencijom, ali problem je što niti perceptron niti SVM s tvrdom marginom nisu definirani kad skup primjera nije linearno odvojiv, a perceptron samo garantira da će naći neku hipotezu koja ih odvaja i ništa ne kaže koju.

Mooooožda se može reći da perceptron “preferira” onu hipotezu do koje ga slučajno odvede gradijentni spust? To je malo čudna preferencija, jer on niti ne zna da postoje ikoje druge, ali zapravo kad bolje razmislim, konzistentno je s rigoroznom definicijom pristranosti…

viliml

Banananjeros Krivo je zadan zadatak jer empirijska pogreška uistinu konvergira i sa linearno odvojivim skupom podataka, stvar je da pritom težine divergiraju.

steker

viliml vrlo moguce, ugl hvala

Banananjeros

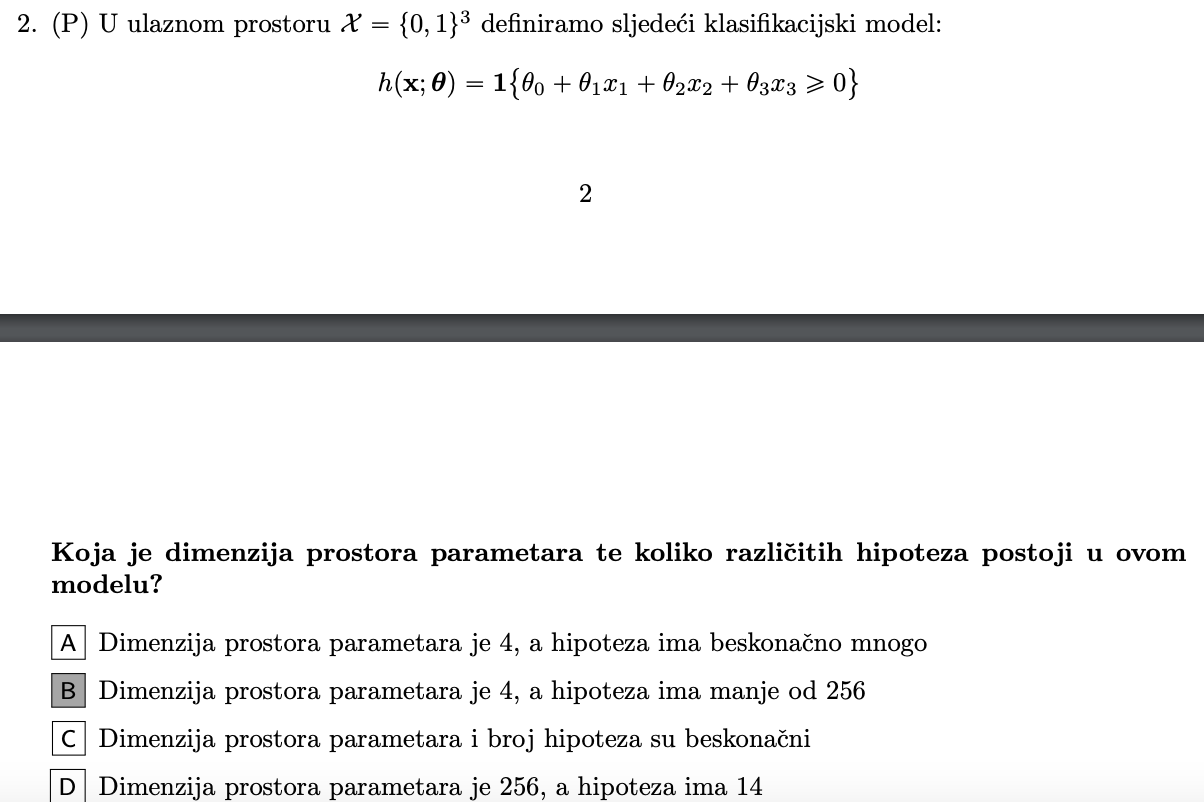

Zašto u jednom zadatku s SVM-om kažemo da beskonačno mnogo hipoteza zadovoljava uvjet savršene klasifikacije, ali u zadacima iz prvih tema kažemo da je broj hipoteza konačan jer vrijedi:

dvije funkcije su jednake ako jednako preslikavaju elemente iz domene u kodomenu

Zar ne bi prema citatu trebali sve te hipoteze smatrati jednom hipotezom jer na isti način preslikavaju primjere pa bi time broj hipoteza bio 1 tj. konačan? Ali, time bi kardinalitet prostora inačica uvijek bio 1.

bodilyfluids

Stvar je u tome da je u zadatku “prostor” primjera Rn. Iako u prostoru inačica jednako klasificiraš sve viđene primjere (tj. sve iz tvog dataseta), postoji beskonačno mnogo neviđenih primjera i svaki pravac će za njih dati malo drugačiju klasifikaciju.

Ovo što citiraš na početku vrlo vjerojatno opisuje klasifikaciju u diskretnom prostoru, npr {0, 1}x{0, 1}x{0, 1}, dakle vrhovi kocke. Tu imaš samo 8 mogućih primjera (označenih i neoznačenih). Ako napraviš malu modifikaciju na ravninu ona će vjerojatno i dalje sve primjere (viđene i neviđene) klasificirati kao i prije, dok u zadatku gore, gdje radimo u kontinuiranom prostoru to očito nije slučaj.

BillIK

ima li netko postupak? ne dobivam točno nikako

viliml

faboche

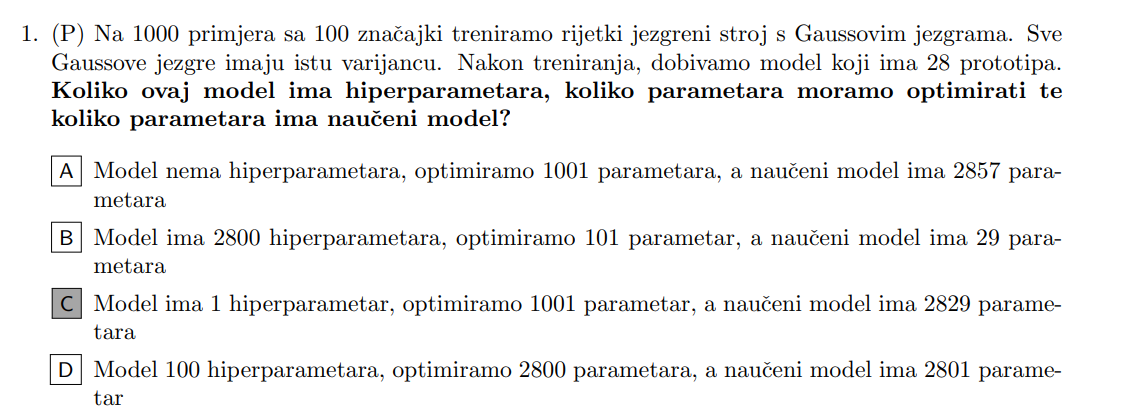

kako dodemo do 1001 i 2829? (jezgrene metode, 1.zdk sa ispita)

Rene

him varijanca gaussovih jezgri je hiperparametar, 28 prototipa×100znacajki + 28 pripadnih alfi + w0 je 2829 parametara, a optimiras 1000 alfi i w0

BillIK

him pogledaj si formulu za gaussovu jezgru. Radiš preslikavanje jezgrenom funkcijom za svaki od N primjera pa ćeš dobiti dobiti Phi (x) = [1, k(x,x_1), k(x,x_2), … k(x,x_N)] i svaka ta jezgrena funkcija je u biti jedna težina, dakle dobivaš N+1 parametara, tj. 1001 (ovaj +1 je za w0). Dakle imaš 1001 parametar

A što se tiče naučenog modela:

dobivaš 28 prototipa, svaki od njih ima 100 značajki (prema tekstu zadatka) to je 28100 = 2800

svakoj značajki pridružuješ jednu težinu, što znači da dobivaš 28 težina + 1 (za težinu w0)

točnije imaš 28100 + 28 + 1 = 2829 parametara naučenog modela

EDIT: kad pišem težina, mislim na alfu

MOXY

zna netko objasniti ovaj?

viliml

MOXY Malo kasniš? To je bilo davno za zadaću.

Nema šta za objasniti, uvrštavaš u formulu.

BillIK

viliml dobar kalkulator pa w0 ne ispadne OTPRILIKE 0.95 nego 1.46

Jaster111

viliml sori učiteljice

viliml

BillIK Kako računaš w0?