[STRUCE1] Gradivo

tomekbeli420

steker oof, ne znam je li to legitimno objašnjenje lmao al ispada dobro

anyways

studoš

znači ako gledaš taj krivi gubitak i malo ga prepraviš

L \left(y, h \left(\mathbf{x}\right) \right) = \left(y + 2 h\left(\mathbf{x}\right)\right)^2 = 4\left(\frac{y}{2} + h\left(\mathbf{x}\right)\right)^2 = 4 \left(- \left(-\frac{y}{2}\right) + h\left(\mathbf{x}\right)\right)^2 = 4 \left( h\left(\mathbf{x}\right) - \left(-\frac{y}{2}\right)\right)^2

primijećujemo da kada bi svaka oznaka y bila pretvorena u -\frac{y}{2} da bi onda takva “kriva” funkcija odgovarala funkciji kvadratnog gubitka i onda bi takav prema metodi najmanjih kvadrata vratio očekivane parametre. Ovaj faktor 4 nije bitan zbog optimizacijskog postupka.

Zaključak: ako uzmemo podatke, transformiramo svaki tako da \mathbf{x} ostane kakav je, ali y promijenimo u -\frac{y}{2}, onda je implementirana funkcija kvadratni gubitak i onda će naučiti parametre za generiranje transformiranih podataka.

Dakle samo se oznaka mijenja, kako je originalno bilo da su y uzorkovane iz \mathcal{N} \left(-1 + 2x, \sigma^2\right), onda skaliranjem se samo mijenja očekivanje, prema tome -\frac{y}{2} onda dolazi iz distribucije \mathcal{N} \left(\frac{1}{2} - x, \sigma^2\right)

I iz toga je vidljivo da ćemo onda dobiti težine \left(w_0, w_1\right) = \left(\frac{1}{2}, -1\right)

Rene

tomekbeli420 drugi način, više računski a manje kreativan, je da napisete funkciju pogreške E(w|D)=(2X\vec{w}+\vec{y})^T(2X\vec{w}+\vec{y}) i izvedete rjesenje najmanjih kvadrata gdje cete dobit \vec{w}' = \frac{-1}{2}w pa isti zakljucak kao kolega

viliml

tomekbeli420 Rene Isusek mileni koji je ovo autizam.

Treba se riješiti zadatak, ne napisati znanstveni rad pobogu.

Vidiš da algoritam ima gubitak (y-g(\mathbf x))^2 gdje je g(\mathbf x)=-2h(\mathbf x). g(\mathbf x) će konvergirati na -1+2x jer je to ispravna linearna regresija, pa se onda vidi h(\mathbf x) = -\frac{1}{2}g(\mathbf x)=\frac{1}{2}-x i gotov si.

tomekbeli420

viliml doslovno si istu stvar napravio, a ja sam onda autist lmao

Rene

viliml coming from you its a hell of a thing to say

Rene

Jel iko uspio onaj s kreditima potrosio sam 15 minuta i nikako dobit

Moja logika je 6 nezavisnih varijabli

6 linearnih + 6 kvadrata + 4 kombinacije za svaku od 15 dvojki + 8 kombinacija za svaku od 20 trojki

bodilyfluids

Rene dvije su multikolinearne barem, starost<- >prihodi i neplaceni-placeni krediti, al idk nisam uspio rjesit

angello2

Rene ja sam nekak zakljucio da je 5 varijabli, s obzirom da za 6 varijabli ispadnu puno puno veci rezultati od ponudenog, pa je valjda x2 suvisan jer kao iz stanja racuna mozes dobit prinose na racun (ne bas al aj…)

naravno problem je bio da cak i za 5 varijabli dobim 130 znacajki a najvise ponudeno je bilo 92

za 4 varijable sam dobio 64 sta isto nije ponudeno

sve u svemu wtf

Rene

Dragi prijatelj strojnog učenja isprobao sam i za 5 i za 4 nezavisne i svejedno nisam dobia nista od ponudenog, tako da mislim da je greska u prebrojavanju

Cak sam probao i izbacit dvojke i trojke di su sve kvadratne opet nista

Rene

angello2 evo ako nesto masno ne grijesim, isprobao sam programski sve moguce kombinacije (broj nezavisnih varijabli, broj dvojki koji se uzima u obzir za neke dvije znacajke, broj trojki koji se uzima u obzir za neke tri znacajke) i jedina moguca rjesenja da se dobije nesto od ponudenog su 6 nezavisnih gdje uzimamo samo po 1 dvojku i 1 trojku (npr samo linearne) ili 7 nezavisnih s 2 dvojke i 1 trojkom

Stvarno ne kuzim

bodilyfluids

Rene svima je priznat ako sam dobro procitao obavijest. Krivo su rjesenja zadali

Još da nisam potrošio 30 min na njega al aj 😄

grga_it_is

Znači grupa A, zašto bi bio krivi 3. B)?

I grupa A, zašto nije 15. C) (jer sam doslovno uvrštavao brojke i provjeravao)?

bodilyfluids

it_is_what_it_is isto sam dobio 3. B, nije mi jasno…

bodilyfluids

it_is_what_it_is jesi gledao apsolutno povećanje il omjer prije-poslije?

tomekbeli420

15 također zbunjen kako jbt, uvrstavao brojke lemao

A kod treceg je opceniti linearan model i granicu se moze fino naginjati tako da ispravno klasificira ona 3 preslikana primjera ali da ima razlike u ostalima iz prostora značajki, pa je zato version space veći od 1

grga_it_is

tomekbeli420 ali zar ne možeš to reći i za recimo koji su oni označili kao točan. To bi bio odsječak na y osi, pa možeš dobiti koliko hoćeš odsječaka?

tomekbeli420

it_is_what_it_is da ali za bilokoji takav odsjecak klasifikacije svih primjera u prostoru znacajki su iste, to je ona situacija da razliciti parametri daju istu hipotezu, kod opcenitog linearnog modela pak dolazi do razlike

grga_it_is

Ali ja mogu kontra primjer dati. Recimo ti si rekao da dobijem različite modele ovisno kako je pozicioniran pravac koji ih razdvaja, a recimo kod odsječka ja isto mogu pozicionirati ga kako želim, pa isto tako dobijem koliko hoćeš modela koji savršeno klasificiraju model.

Zanči različiti parametri za odječak daju različiti model po toj logici.

tomekbeli420

it_is_what_it_is uzmi u obzir da je prostor primjera parovi cijelih brojeva, ako i dalje si uvjeren okej možeš li dati dvije hipoteze koje nisu iste a dobro klasificiraju ulazne primjete

grga_it_is

tomekbeli420 JAOO TO NISAM VIDIO 😂😂😂

bodilyfluids

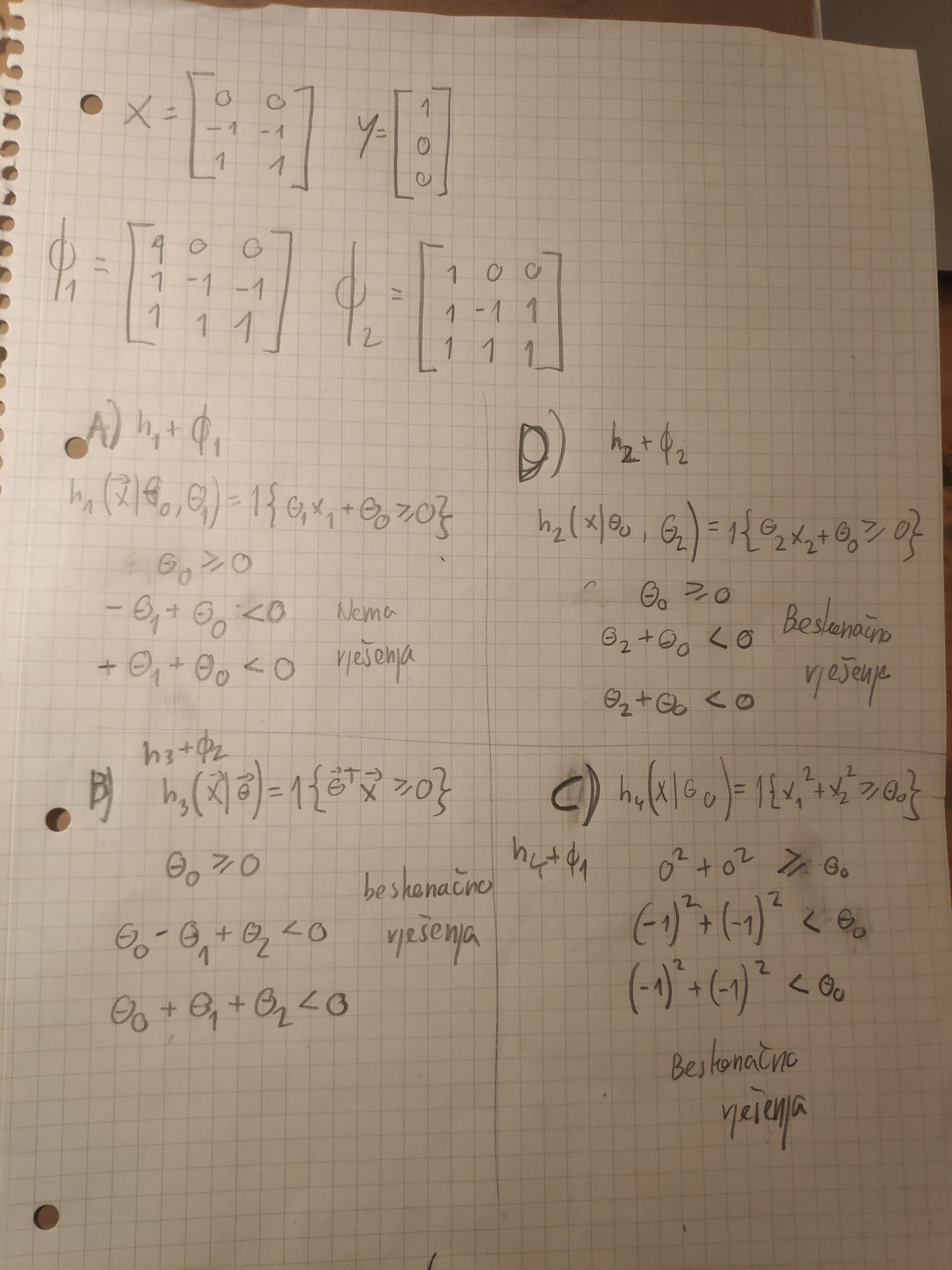

Evo ovak sam rješavo 3. u grupi A, ne ispada mi nigdje |Vs| = 1 . Vidi itko grešku?

viliml

Dragi prijatelj strojnog učenja Hipoteze se ne broje po parametrima nego po različitim outputima.

Za D, granica zapravo odvaja x_2 vrijednosti, i točno je jedna granica koja točno klasificira primjere: ona između 0 i 1.