[STRUCE1] Gradivo

viliml

bodNaUvidima h(\mathbf x) ti je točan, kako računaš w0 da ti ispadne krivo? Trebao bi takav da je h(\mathbf x^{(i)})=y^{(i)}. Što dobiješ za h(\mathbf x^{(i)})?

bodNaUvidima

viliml w0 pokušavam izračunati preko ove formule iz P08 pdfa

Ako uzmem 3. potporni vektor sa oznakom y=+1, uvrstim u tu formulu dobijem w0 = 0.999998026, svakako predaleko od 0.95.

bodNaUvidima

bodNaUvidima Da odgovorim sam sebi, imao sam brain fart i nisam koristio kernel funkciju nego samo mnozio dva vektora.

ppooww

Jel ovo znaci da mozemo 2 pitanja krivo zaokruzit bez negativnih? Ili tocni odgovori nose 35/20 bodova, a krivi odgovori -⅓ * 35/20 ?

Sulejman

pp Rekao bih da dobiješ negativne ako krivo odgovoriš, sumnjam da bi ti dopustili da dvaput besplatno pogađaš. Ali da, ak odgovoriš na 21 pitanje točno onda možeš fulat jedno 😅

Reznox

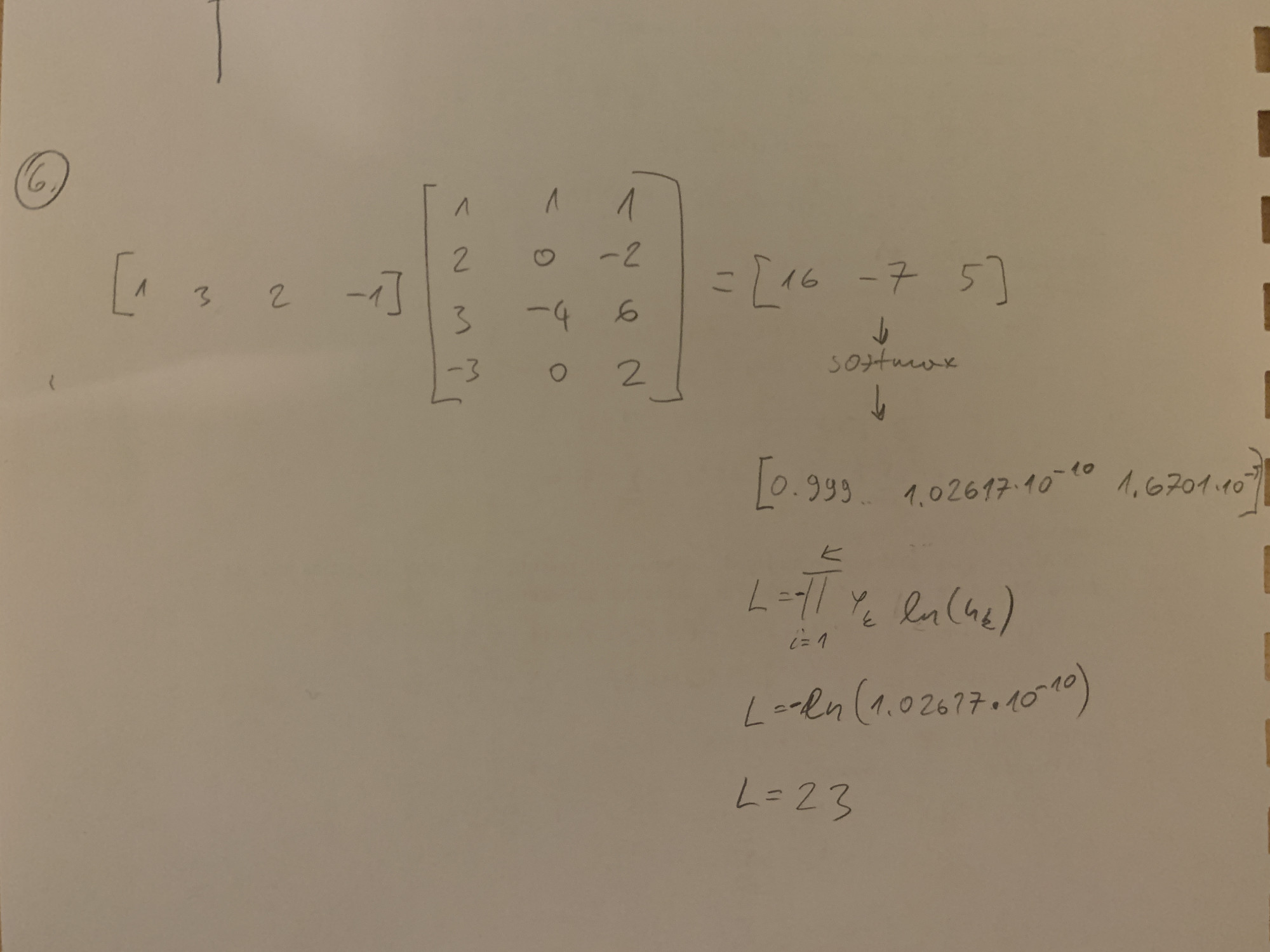

Ima ko postupak?

boogie_woogie

boogie_woogie

Zna netko ovaj?

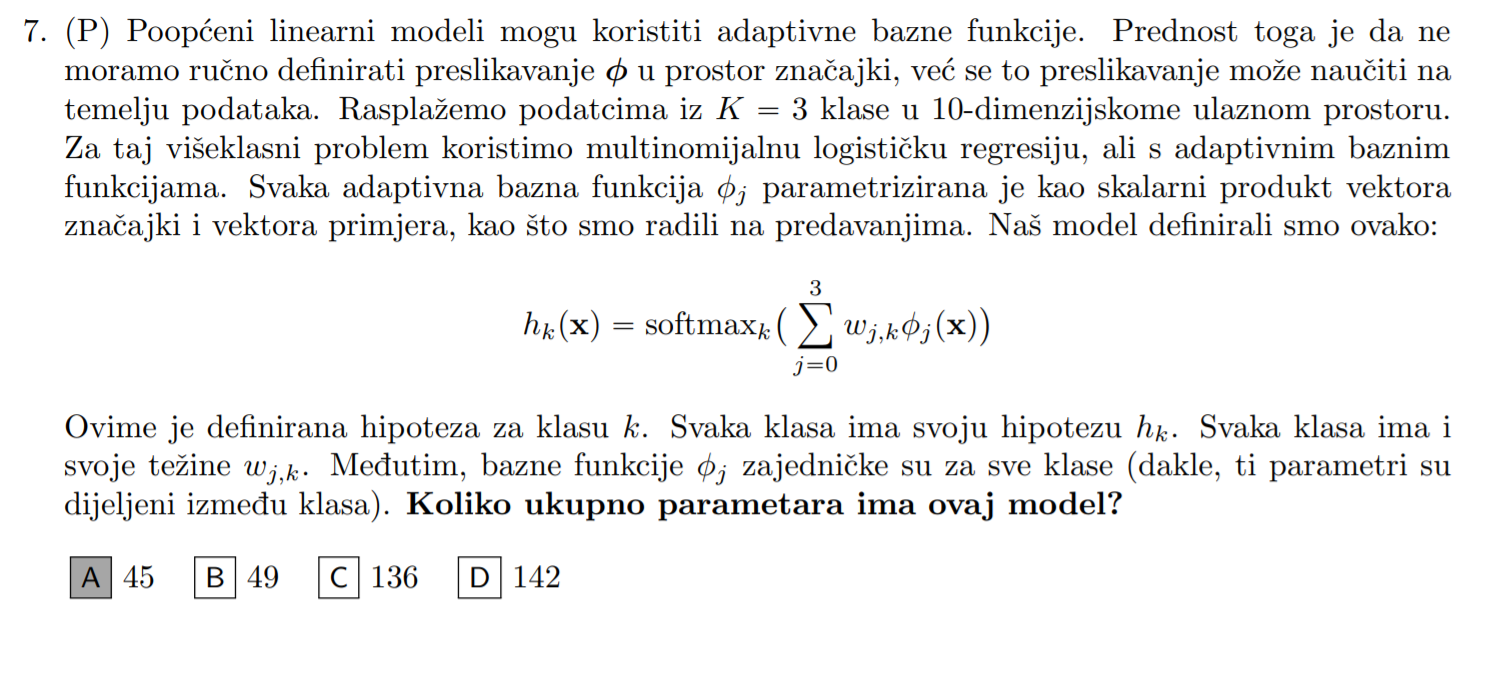

angello2

moze neki savjet oko ovakvih zadataka di se trazi broj parametara? krenem ja tu nesto brojat i dobijem neki broj al nikad ne dobim tocno rjesenje tak da mi ocito nesto fali

bodilyfluids

angello2 zadnji je rješio Medić, na identičan način se rješi i prvi. drugi je rješio tatica, isto na predavanju.

Uostalom, većina zadataka je rješena na predavanjima, a ona su sva su dostupna u repozitoriju na teamsu.

zastozato

ovaj? zašto?

zastozato

studoš točan odg je C

steker

studoš ja sam to shvatila ovako: model ima 6 svojih wj tezina. Imamo 5 fi j parametriziranih baznih funkcija gdje svaka ima n+1 tezina tj svaka ima 101 tezinu, jos dodatno imamo i tu fi 0 baznu funkciju koju na predavanju nismo parametrizirali pa onda imamo: 5*101 tezina baznih funkcija + 6 tezina modela= 511. Valjda…

bodilyfluids

steker Znači imamo 5 baznih funkcija koje preslikavaju na način da implementiraju logističku regresiju, dakle svaka 100 + 1 parametara? A što točno predstavlja \phi_0? Jel to simulira dummy značajku, as in \phi(x) = 1, pa nema parametara? Ima smisla, al ne vidim tu pretpostavku nigdje u skripti predavanja tho…

steker

Dragi prijatelj strojnog učenja nez ja znam da je snajder reko kad je rjesavo slican zadatak da je to dogovorno jednako 1. Ali ocito bi trebalo simulirat nesto valjda kao prag u neuronskoj mrezi lmao

InCogNiTo124

Dragi prijatelj strojnog učenja phi_0 je po dogovoru uvijek 1 to se sjecam da je nama govorio

gladiator

Dragi prijatelj strojnog učenja phi_0 je 1, to je jasno kao dan, ali upitan je w0. Zato taj 101. parametar

zastozato

a ovaj? odg je a

steker

studoš valjda jer je sum malen mozes rec da je y= -1+2x

Za optimizacijski postupak znas da zelis minimizirat (y+2h(x))2 pa izjednacis sa 0 valjda

Korjenujes tu jednadzbu i dobijes 2h(x)=-y

2h(x)=-(-1+2x)

h(x)=½ -1x

tomekbeli420

steker oof, ne znam je li to legitimno objašnjenje lmao al ispada dobro

anyways

studoš

znači ako gledaš taj krivi gubitak i malo ga prepraviš

L \left(y, h \left(\mathbf{x}\right) \right) = \left(y + 2 h\left(\mathbf{x}\right)\right)^2 = 4\left(\frac{y}{2} + h\left(\mathbf{x}\right)\right)^2 = 4 \left(- \left(-\frac{y}{2}\right) + h\left(\mathbf{x}\right)\right)^2 = 4 \left( h\left(\mathbf{x}\right) - \left(-\frac{y}{2}\right)\right)^2

primijećujemo da kada bi svaka oznaka y bila pretvorena u -\frac{y}{2} da bi onda takva “kriva” funkcija odgovarala funkciji kvadratnog gubitka i onda bi takav prema metodi najmanjih kvadrata vratio očekivane parametre. Ovaj faktor 4 nije bitan zbog optimizacijskog postupka.

Zaključak: ako uzmemo podatke, transformiramo svaki tako da \mathbf{x} ostane kakav je, ali y promijenimo u -\frac{y}{2}, onda je implementirana funkcija kvadratni gubitak i onda će naučiti parametre za generiranje transformiranih podataka.

Dakle samo se oznaka mijenja, kako je originalno bilo da su y uzorkovane iz \mathcal{N} \left(-1 + 2x, \sigma^2\right), onda skaliranjem se samo mijenja očekivanje, prema tome -\frac{y}{2} onda dolazi iz distribucije \mathcal{N} \left(\frac{1}{2} - x, \sigma^2\right)

I iz toga je vidljivo da ćemo onda dobiti težine \left(w_0, w_1\right) = \left(\frac{1}{2}, -1\right)