[STRUCE1] Gradivo

Fica

Rene Imaš ovaj prvi detaljno objašnjen u snimci sa zadnje rekapitulacije na teamsima, uglavnom za ovu jezgru se izvede preslikavanje (x12, sqrt(2)x1x2, x22), a sa polinomom dobiješ standardno (1, x1, x2, x12, x1×2, x22) i onda ovom prvom dodaš samo 3 nule na početak jer tih članova tamo nemaš i onda ti je euklidska udaljenost zbroj kvadrata razlike za svaki od njih. Kad uvrstiš primjer dobiješ za jezgreni (0,0,0,0,1,0), a za ovaj (1,1,0,0,1,0) i onda je to korijen iz 12 + 12 i to ti je rješenje.

viliml

Ivančica

w_1 = \sum_{i=1}^{N} \alpha_i y^{(i)} x^{(i)}_1

[obrisani korisnik]

u d) podzadatku i generalno takvim tipovima zadataka, jel uvijek gledamo s dummy jedinicom? odnosno treba li nam u slučaju bez preslikavanja 4 primjera? (3 značajke + dummy)

ili ako nije direktno naglašeno da je preslikavanje (1, x) ignoriramo?

viliml

Rene Za drugi zadatak, uvijek je moguće barem teoretski izračunati udaljenost

d(\mathbf{x})=\frac{h(\mathbf{x})}{||\mathbf{w}||}=\frac{\sum_i{\alpha_i y^{(i)} \kappa(\mathbf{x},\mathbf{x}^{(i)} )}+w_0}{\sqrt{\sum_i{\sum_j{\alpha_i \alpha_j y^{(i)} y^{(j)} \kappa(\mathbf{x}^{(i)}, \mathbf{x}^{(j)} )}}}}

Možda se referenciraju na to da je prostor značajki za Gaussovu jezgru neprebrojivo-beskonačno-dimenzionalan pa sumiranje po dimenzijama i slične stvari nisu zapravo definirane, ali s konkretnom hipotezom će se sve događati u konačno- ili prebrojivo-beskonačno-dimenzionalnom podprostoru gdje sve sume koje nam trebaju konvergiraju…

viliml

tomekbeli420 Nije strogo nužno eksplicitno izračunati težine niti koristiti funkciju preslikavanja pošto se sve može prikazati preko unutarnjih produkata/jezgri, vidi viliml

Jedino je možda problem da ta formula vrijedi ako udaljenost postoji, možda se može reći da udaljenost ne postoji pa ta formula iako daje neki broj nije baš rigorozno točno zvati “udaljenost”?

prx_xD

viliml jel možeš objasniti kako K(x, z) = (xT*z + 2)3 rješiš

viliml

prx_xD To je formula. Staviš brojeve unutra i izađu brojevi van.

Na primjer \kappa(\mathbf{x}^{(3)}, \mathbf{x})=17^3.

Mnoge vrijednosti će biti u milijunima ali zato su koeficijenti jako mali.

[obrisani korisnik]

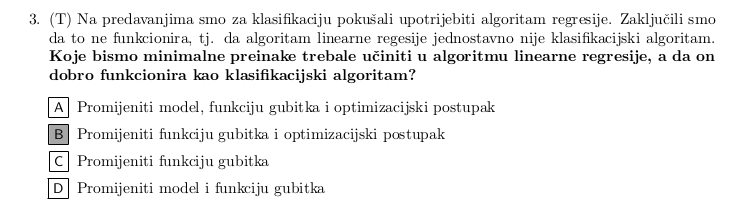

Prošli tjedan bavili smo se regresijom te smo razmatrali linearan model regresije, koji – uz odabir nelinearne funkcije preslikavanja – zapravo postaje nelinearan model.

Ovaj model sada ima linearnu granicu u prostoru značajki, ali nelinarnu granicu u ulaznom prostoru. Tehnički gledano to je i dalje linearan model, jer je linearan u parametrima.

šta je od ovog onda na kraju, jel se model smatra linearnim ili ne lol

bodilyfluids

[obrisani korisnik] Pa… I dalje je to linearan model jer on u prostoru značajki stvara linearnu granicu. Nelinearnost nastaje prilikom preslikavanja u prostor značajki, a to nije unutar “okvira djelovanja” modela. Bar si ja tako tumačim…

[obrisani korisnik]

Dragi prijatelj strojnog učenja da, kuzim, zato me i muči ovaj “postaje nelinearan model” dio

bodilyfluids

[obrisani korisnik] poanta je valjda da ako gledaš to kao crnu kutiju zaključit ćeš da je nelinearan model, al zapravo se radi o preslikavanju koje se feeda u običan linearan model. Tako da su vjerojatno oba pogleda točna, samo treba biti svjestan konteksta.

[obrisani korisnik]

jel nije poanta doslovno bila da ako promijenimo funkciju gubitka da to više nije linearna regresija?

također, jel promjena aktivacijske funkcije ne spada u promjenu modela?

kix7

[obrisani korisnik] Mislim da oce rec da nas je najvise mucio onaj kvadratni gubitak i da je dovoljno da njega promijenimo da ce funkcionirat linearna regresija a uz to dolazi i promjena optimizacijskog postupka.

Al da, lakse je opravdat odgovor kad znas vec rjesenje…

bodilyfluids

[obrisani korisnik] možda je greška? Valjda se implicira da se nabroje promjene koje iz lin. reg. daju perceptron, a među njima je dodavanje aktivacijske funkcije u model, čime se on mijenja.

viliml

[obrisani korisnik] Dragi prijatelj strojnog učenja Kad se linearna regresija koristi za klasifikaciju, odmah već mora imati aktivacijsku funkciju. U skripti se koristi funkcija \mathbf{1}\{\alpha\ge0.5\}, ali to je ekvivalentno step funkciji do na promjenu w0 i preimenovanje izlaznih klasa iz 0/1 u =+-1 (Jaster111 ) znači algoritam ekvivalentan perceptronu se može dobiti bez promjene aktivacijske funkcije.

tomekbeli420

Ivančica e sry tek sad vidio

vektorsko zbrajanje, dakle \alpha_i i y^{(i)} su skalari, a \mathbf{x}^{(i)} su vektori

\mathbf{w} = \alpha_1 y^{(1)} \mathbf{x}^{(1)} + \alpha_2 y^{(2)} \mathbf{x}^{(2)} + \alpha_3 y^{(3)} \mathbf{x}^{(3)} \\

\mathbf{w} = 0 \cdot (-1) (-1, 3, 6) + 0.01 \cdot (-1) (-4, 4, 4) + 0.01 \cdot 1 (-2, 4, 1) \\

\mathbf{w} = (0, 0, 0) + (0.04, -0.04, -0.04) + (-0.02, 0.04, 0.01) = (0.02, 0, -0.03)

I onda kako je \mathbf{w} = \left(w_1, w_2, w_3\right) odavdje iščitaš sve šta te zanima

Zuzu

viliml možeš reć molim te kako dobiješ vrijednosti za ostale vektore, znači -1.97711, -1.92673 i 0.05117..nikako ne mogu dobiti te vrijednosti formulama pa nešto vjv krivo radim

-Ivan-

tomekbeli420

hvala na odgovoru, sam mi još jedna stvar nije baš jasna, kako si dobio ove brojeve (zaokruženo plavom)

nemrem skužit kaj si s čim pomnožio, što god pokušam gledajući ovu formulu ne dobim te brojeve

viliml

Ivančica

h \left(\mathbf{x}\right) = \mathbf{w}^{\mathrm{T}} \mathbf{x} + w_0

Vrijednosti \mathbf{w} i w_0 su pokazane izračunate gore u njegovom odgovoru, a primjeri \mathbf{x} su zadani u zadatku.

tomekbeli420

Ivančica to su izlazi modela

A s obzirom da smo našli težine \mathbf{w} = (0.02, 0, -0.03), i u zadatku nam je dan w_0 = -0.8, onda hipotezu možemo računati sa primarnom formulacijom modela, koji je običan linearan model

h \left(\mathbf{x}\right) = \mathbf{w}^{\mathrm{T}} \mathbf{x} + w_0

tako npr za primjer \left(\mathbf{x}^{(3)}, y^{(3)}\right) = \left((-2, 4, 1) , +1\right) izlaz modela je

h \left(\mathbf{x}^{(3)}\right) = (0.02, 0, -0.03) \cdot (-2, 4, 1) - 0.8 = -0.87

bodilyfluids

Jel zna netko ovo objasniti? Iz zadataka logističke regresije I

možemo li reći da je logistički gubitak konveksni surogat gubitka 0-1, i što to znači?

viliml

Dragi prijatelj strojnog učenja To je jedan termin koje je definiran tek kasnije, vjerojatno su ga greškom stavili u tu vježbu.

zara

Jel zna netko?

bodilyfluids

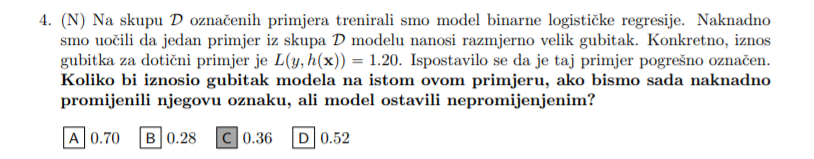

Iz poznate vrijednosti fje gubitka i proizvoljne oznake y možeš izračunati izlaz modela h(x), nakon toga pomoću izračunatog h(x) i suprotne vrijednosti y izračunaš gubitak.

viliml

zara Zamjena oznake znači invertiranje vjerojatnosti, pa se u gubitku zamjeni -log(p) sa -log(1-p). Dakle rješenje je -log(1-exp(-L)).

zastozato

jel ima netko rjesen 2. iz Jezgrenih metoda zadatci za učenje