[STRUCE1] Gradivo

[obrisani korisnik]

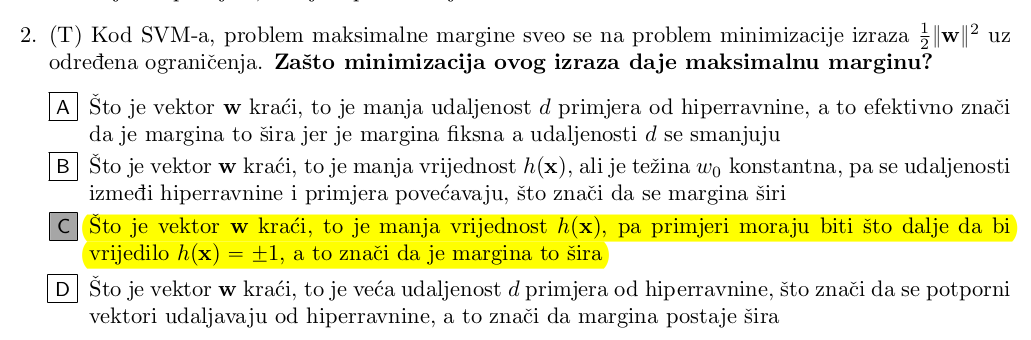

moze netko objasnit zasto je ovo C, a ne npr D

bodilyfluids

D nije tocan jer se pozicija hiperravnine ne mijenja porastom vektora w, isto vrijedi i za udaljenost primjera od hipperavnine, mnozenje vektora skalarom ne utjece na udaljenost.

Ono što se mjenja je izlaz modela, h(x) i on raste proporcionalno porastom w.

BillIK

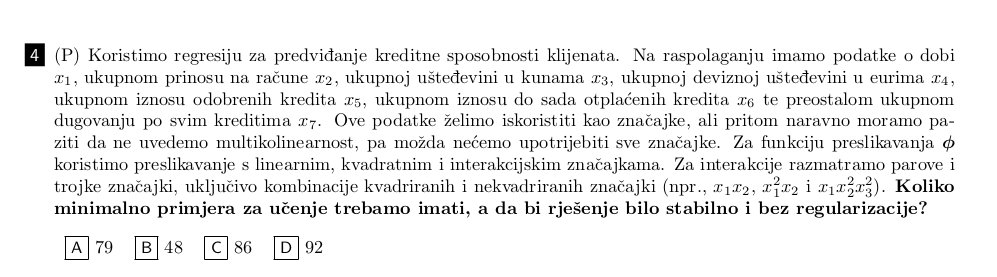

Bi li u ovome zadatku isključili x4 jer je u zavisnosti s x3 (ako dobro razmisljam)?

Koliko bi bilo rješenje jer zbunjuje me ovo s parovima i trojkama kvadrata. Uzimamo li u obzir da npr. za par imamo mogucnost birati dva elementa od 6 mogucih ili od 12?

angello2

BillIK to su dva odvojena racuna, nisu u ovisnosti

reko bi da je x7 suvisan jer ga mozes izracunat iz ostalih podataka - imas ukupan iznos kredita i imas iznos otplacenih, ne treba ti podatak koliko je preostalih. istom logikom se moze maknut bilo koji od x5, x6, x7 - dovoljna su dva od ta tri.

viliml

tomekbeli420 Nije strogo nužno eksplicitno izračunati težine niti koristiti funkciju preslikavanja pošto se sve može prikazati preko unutarnjih produkata/jezgri, vidi viliml

Jedino je možda problem da ta formula vrijedi ako udaljenost postoji, možda se može reći da udaljenost ne postoji pa ta formula iako daje neki broj nije baš rigorozno točno zvati “udaljenost”?

gad_gadski

endyyyy

Pretpostavljam da nisi stavila izraz -(wx + w0) u potenciju kod formule za h(x), vec samo -wx

matt

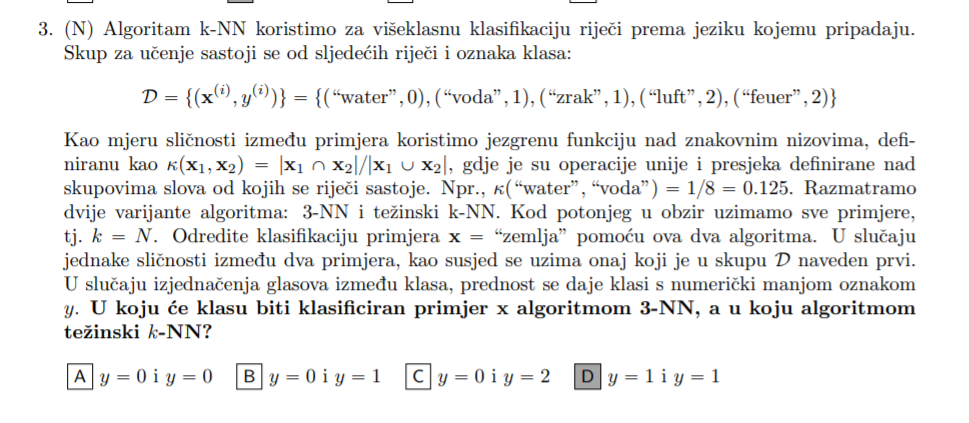

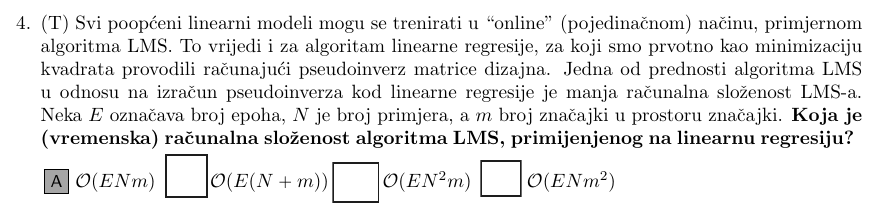

V07 4. Zadatak: Svi poopćeni linearni modeli mogu se trenirati u “online” (pojedinačnom) načinu, primjernom

algoritma LMS. To vrijedi i za algoritam linearne regresije, za koji smo prvotno kao minimizaciju

kvadrata provodili računajući pseudoinverz matrice dizajna. Jedna od prednosti algoritma LMS

u odnosu na izračun pseudoinverza kod linearne regresije je manja računalna složenost LMS-a.

Neka E označava broj epoha, N je broj primjera, a m broj značajki u prostoru značajki. Koja je

(vremenska) računalna složenost algoritma LMS, primijenjenog na linearnu regresiju?

Iz predavanja:

Nije mi jasno zašto se pojavljuje izraz m, tj. koja operacija uzrokuje tu kompleksnost?

Je li to operacija preslikavanja \phi(x) ili izračun skalarnih produkta unutar izraza za ažuriranje težine w?

viliml

Matt Za svaku epohu, za svaki primjer, svaka težina se mora ažurirati.

Ovo u tvojoj drugoj slici je vektorska jednadžba koja je skraćeni prikaz za m zasebnih operacija.

RickyMorty

Kak se ovo točno radi, tojest nije mi jasno odkud mi po dvije težine za x1 itd…

bodilyfluids

RickyMorty Ovaj zadatak je detaljno objašnjen na teams predavanjima.

Antuunn

zara Jel pronadeno rjesenje za ova dva zadatka?

gad_gadski

Ovo je mi s materijala na studosima, u rj pise da je A tocno, jel to krivo ili? Ja nevidim kako nije C

bodilyfluids

Grafički se lagano rijesi

bodNaUvidima

tomekbeli420 Je si li uspio ovdje doci do njihovog rjesenja? Takoder mi h(x) ispada 1.06 x 10^{-3} + w0, a w0 mi ispada 0.999999 po njihovoj formuli.

bodilyfluids

bodNaUvidima rješio ga je Šnajder na predavanju

viliml

bodNaUvidima h(\mathbf x) ti je točan, kako računaš w0 da ti ispadne krivo? Trebao bi takav da je h(\mathbf x^{(i)})=y^{(i)}. Što dobiješ za h(\mathbf x^{(i)})?

steker

Kako se ovo rjesava

[obrisani korisnik]

steker značajke == klasifikatori, i onda kad napravis K, odnosno K povrh 2 vidiš da OVO ima duplo, a OVR lošije radi na “znanost” kategoriji jer je osjetljiv na class imbalance, odnosno ima jako malo primjera pa ih “trpa” u većinsku klasu i tako griješi

steker

[obrisani korisnik] aha zbunjivalo me taj dio sa znacajkama

batman3000

E zna netko?