[STRUCE1] Gradivo

steker

Kako se ovo dobije

Fica

ostaje.mi.to.sto.se.volimo Za OVO si uzeo samo jednu klasu, a trebalo bi usporediti dvije najveće pa dobiješ 800 primjera, a ne 400. I inače jedan tip za sve, veliku većinu tih zadataka sa ispita imate riješenih na teamsima na videu od tjedna gdje se to radilo ili na rekapitulaciji.

steker

ostaje.mi.to.sto.se.volimo jel nebi za ovo trebala 800×800 matica da bi bila simetricna

pvmnt

steker bravo. sjeban sam, od jutros sam za laptopom. hvala

prx_xD

Može netko dat postupak za ovaj zadatak nije mi jasno kak ga rijesit

Tocan odg je pod B

steker

prx_xD

Valjda je to to

viliml

prx_xD steker Dragi prijatelj strojnog učenja

Nije toliko ružno ako zguraš sve detalje linearno algebarskih računa pod tepih. Na primjer vrijednosti hipoteze za sve primjere možeš odmah izračunati trikom da daš jezgri za argument matricu umjesto vektora, i sve one sume s alfama i ipsilonima se isto mogu prikazati kao matrično množenje.

Ovo je isti zadatak s drugačijim krajnjim primjerom x:

prx_xD

steker hvala

bodilyfluids

steker odvratan zadatak lol

bodNaUvidima

gad_gadski predavanje na teamsu iz te lekcije Šnajder rješi isti zadatak samo druge brojke.

steker

moze neko pametan mi malo pojasnit zasto se minimizira druga norma od W za rjesenje maksimalne margine, tj. Zasto se potporni vektori udaljavju vise od hiperravnine sto je W manji. Nikako mi to ne ide u glavu baš

bodilyfluids

steker dosta je dense izvod, probaj shvatit svaki korak pojedinačno.

Keypointovi za razumjet su (SVM 1, poglavlje 1.1):

- definicija udaljenosti primjera od hiperravnine

- izraz za maksimalnu marginu (minimizacija unutar argmax-a),

- uvođenje pretpostavke da je udaljenost potpornih vektora od klasifikacijske granice jednaka 1,

- činjenica argmax(1 / ||w||) ekvivalentna argmin ||w||.

AK10

kako?

bodilyfluids

Iz fje gubitka izračunaš h(x). Pomoću h(x) i w0 izraziš wT x, zatim ga pomnoži s 2 i na kraju novi h(x) = 2wT x + w0 i obrnutu oznaku ubacuješ nazad u funkciju gubitka i to je rješenje.

Dootz

Može li netko objasniti ovo?

tomekbeli420

Dootz Da bi računao udaljenost od hiperravnine u prostoru značajki trebaju ti težine i preslikani primjeri. Funkcija preslikavanja je implicitno poznata iz korištene jezgre (kako se radi o algoritmu SVM onda možemo biti sigurni da je jezgra Mercerova), pa onda iz Lagrangeovih multiplikatora \alpha_i i preslikanih ulaznih primjera se lako dobiju težine \mathbf{w}. Dakle to je sve moguće, jedino problem sa Gaussovom jezgrom ili složenijim koje koriste Gaussovu jezgru kao gradivni blok jest taj da je preslikavanje beskonačno dimenzijsko, pa je to valjda (nisam ni ja siguran lmao) razlog zašto se ne može sa Gaussovom jezgrom.

123

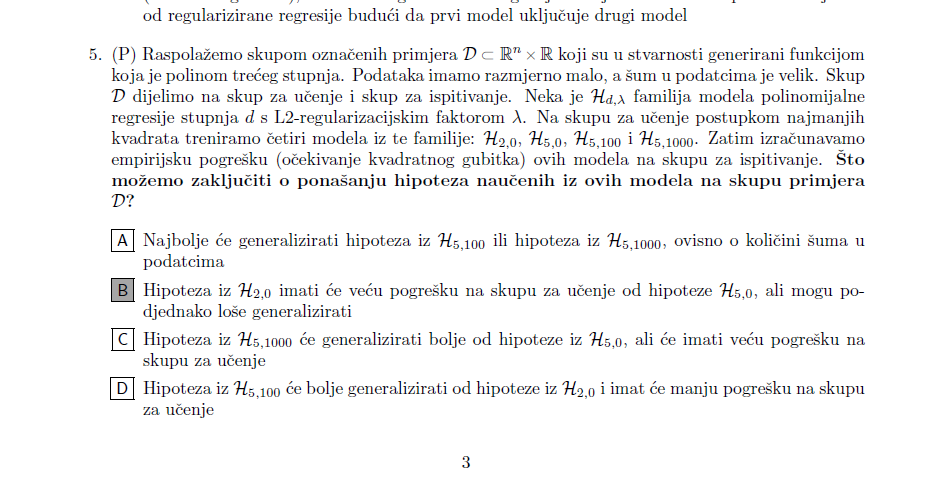

Zna li netko zašto ovdje ne bi mogao bit odgovor pod D?

Rene

FERella jer ne znamo kako regularizacija utjece na model, mozda je s tolikim faktorom model jos jednostavniji od H2,0

nnn

FERella Neka me netko ispravi ali sjećam se da sam pričao sa asistenticom i stvar je da ne možeš ništa reći o generalizaciji hipoteza, i ovaj drugi dio “imat će manju pogrešku na skupu za učenje” ne mora nužno bit točno. Možda je lambda=100 prevelik faktor i greška je puno veća

AK10

Dragi prijatelj strojnog učenja to radim ali iz nekog razloga mi ne ispada dobro, ako mozes uslikat postupak bila bih jako zahvalnaa

gad_gadski

endyyyy

Pretpostavljam da nisi stavila izraz -(wx + w0) u potenciju kod formule za h(x), vec samo -wx

viliml

tomekbeli420 Nije strogo nužno eksplicitno izračunati težine niti koristiti funkciju preslikavanja pošto se sve može prikazati preko unutarnjih produkata/jezgri, vidi viliml

Jedino je možda problem da ta formula vrijedi ako udaljenost postoji, možda se može reći da udaljenost ne postoji pa ta formula iako daje neki broj nije baš rigorozno točno zvati “udaljenost”?