[STRUCE1] Gradivo

Rene

Ducky to je opet prebrojavanje parametara za bayesov klasifikator, imas slicnih vec rjesenih u temi

Moze se rjesit preko formula za broj parametara, ali meni je lakše ić po mreži:

H1: treba ti 2 parametra za P(y), za svaku od 3 vrijednosti y ti treba po 2 parametra za x1, x2 i x3, dakle ukupno 2 + 3 \cdot 2 + 3\cdot 2 + 3\cdot2 = 20

H2: treba ti 2 parametra za P(y), za svaku od 3 vrijednosti y ti trebaju 2 parametra za x1 i x2, a za svaku od 9 kombinacija y i x2 ti trebaju 2 parametra za x3: 2 + 3\cdot 2 + 3\cdot 2 + 9\cdot 2 = 32

H3: treba ti 2 parametra za P(y), za svaku od 3 vrijednosti y ti trebaju 2 parametra za x1, za svaku od 9 kombinacija x1 i y ti treba 2 parametra za x2 i za svaku od 9 kombinacija x2 i y ti treba 2 parametra za x3: 2 + 3\cdot2 + 9 \cdot 2 + 9\cdot 2 = 44 .

“Parametar” ovdje znači definirati vjerojatnost za pojedinu kombinaciju.

Ducky

Rene hvala na postupku, ali nije još mi nije jasno teoretski odkud ti parametri dolaze.

Recimo, na primjer, da su klase true (T), false (F) i ne znam (IDK). Zašto mi trebaju 2 parametra za P(y)?

sheriffHorsey

Ducky treci parametar uvijek mozes dobit preko uvjeta \sum_{i=1}^{K} P(y = i) = 1 pa zapravo trebas zapamtiti samo dva

bodilyfluids

Ducky ak imas kategoricu varijablu s 3 stanja, možeš ju modelirat s dva parametra, recimo

P(y=T) = 0.2

p(y=F) = 0.3

p(y=Ne znam) = 1 - P(y=T) - P(y=F) jer suma mora biti 1

To bi bilo da varijable nije ovisna ni o kojoj drugoj. A recimo da sad y ovisi o x, koji ima 2 stanja. Pa imaš

P(y=T | x=0) = …

p(y=F | x=0) = …

p(y=Ne znam | x=0) = ovaj dobivaš od prethodna dva

P(y=T | x=1) = …

p(y=F | x=1) = …

p(y=Ne znam | x=1) = ovaj dobivaš od prethodna dva

dakle broj parametara koliko bi ti trebalo od y apriorno * broj stanja od x.

Ne znam jel ova logika korektna, al uspio sam tako rješiti većinu sličnih zadataka

-Ivan-

Ovo je super ezi zad al opet negdje griješim mada nekužim di.

P(y|x=0, z=1) = P(x=0) * P(y=0) * P(z=1|x=0, y=0) + P(x=0) * P(y=1) * P(z=1|x=0, y=1)

P(…) = 0.8 * 0.7 * 0.9 + 0.8 * 0.3 * 0.8 = 0.696

500 * 0.696 = 348

Nije ponuđeno?

bodilyfluids

Ivančica ovo je broj prihvaćenih uzoraka, trebaš to oduzet od 500, jer se traži broj odbačenih

-Ivan-

Dragi prijatelj strojnog učenja

eh kad ne čitam podrobno

tenkju

bodilyfluids

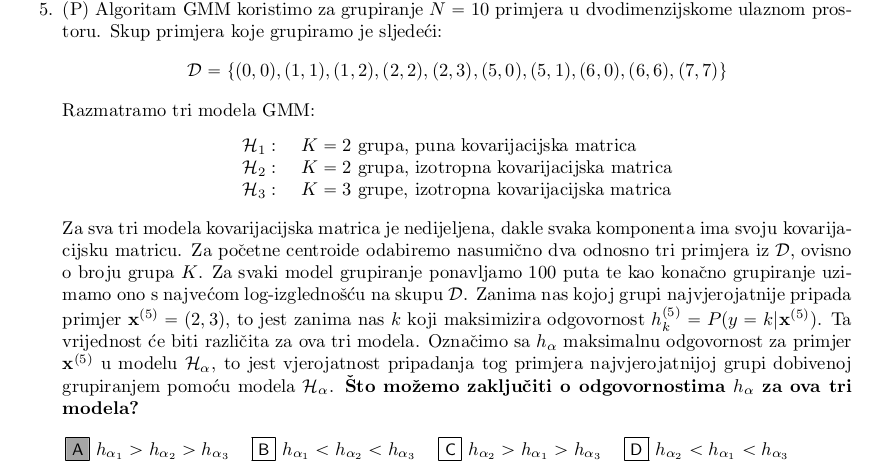

ima netko tumačenje ovoga?

-Ivan-

Dragi prijatelj strojnog učenja

Ako se dobro sjećam, Šnajder je rješavao ovaj zadatak i rekao da se ne slaže s rješenjem, točnije s ovim ha2>ha3

Kao da to ne možemo zapravo znati je li taj dio vrijedi

bodilyfluids

Ivančica mene taj dio isto buni, ali bi mi imalo smisla da je obrnuto, onda bi se grupe mogle fino poravnati

Reznox

Moze neko pojasnit?

bodilyfluids

Reznox znaci da ispobavas svaku kombinaciju C i gamma. resetka as in kartezijev produkt

Rene

Reznox

10 puta vrtis vanjsku petlju, ali u 9 slucajeva ce svaki primjer biti u train setu a jednom u test setu

Svaki put u vanjskoj petlji prolazis sve hiperparametre dakle 31 (linearna jezgra) + 31×31 (rbf)

U unutarnjoj petlji 4 od 5 puta ce biti u train setu, a jednom u validation

Na kraju vanjske petlje jos istreniras s najboljim parametrima i testiras

9 \cdot ((31 + 31^2) \cdot 4 + 1) = 35721

Ako nisi baš skužio pogledaj pseudokod ove ugniježđene provjere pa si probaj vizualizirat

branimir1999

Postoji neka preporuka kako uciti za rok? Ishodi ucenja, skripta, stari zadaci i videopredavanja?

Bananaking

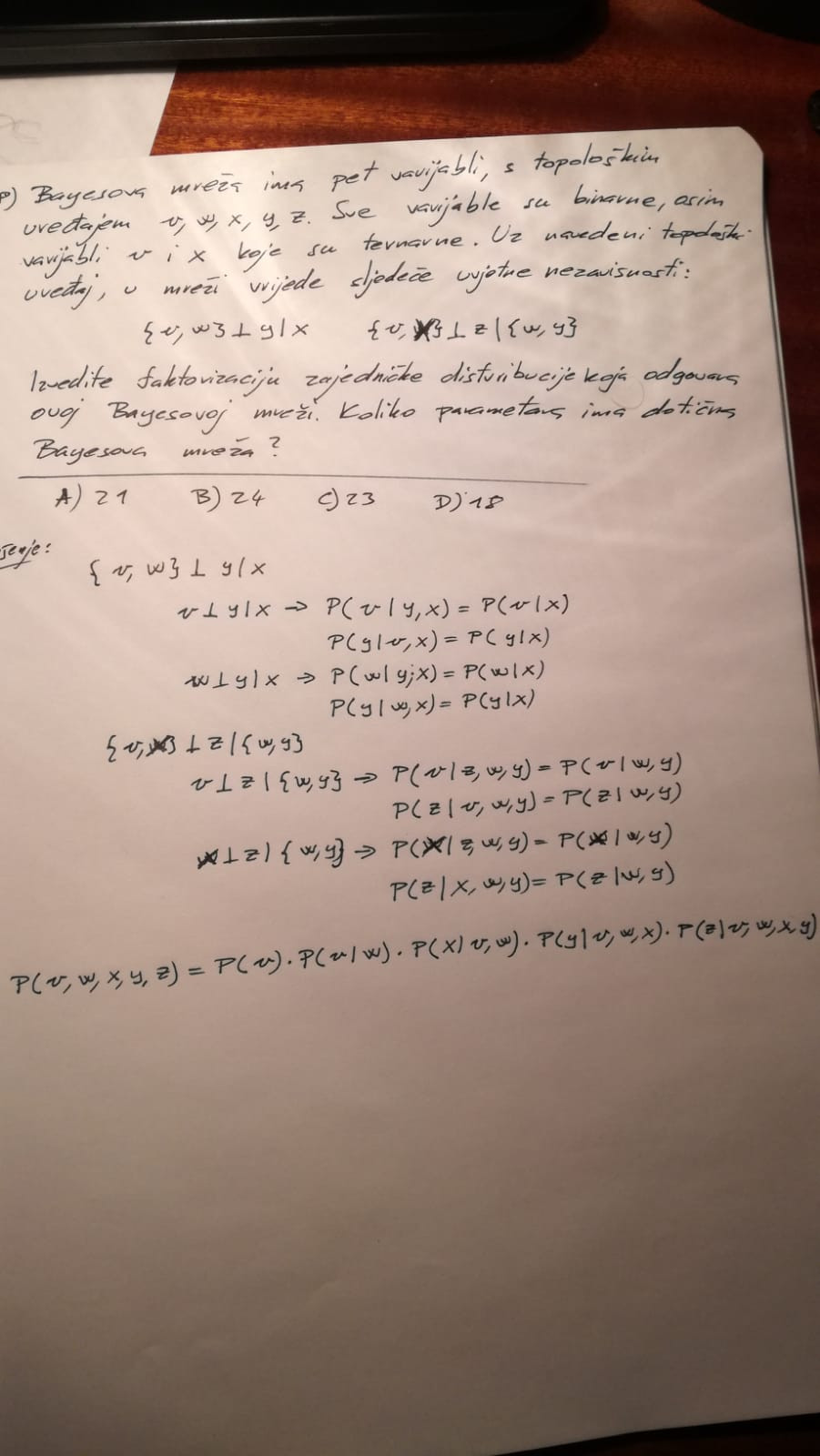

Rješavam ZI pa bi stavio rješenja za sve osim gradivo koje nisam prošao (Bayesov klasifikator, ako netko je može staviti svoja rješenja), došao sam do ovog zadatka. Jel bi ga mogao netko raspisati? Ne znam jel dobro raspisujem nezavisnosti odnosno kako se dekomponiraju kad imam skupove npr {v, w}. Ima mi smisla da se to rastavi na dvije, v / y | x i w / y | x ali mi malo mršavo izgleda pool nezavisnosti s kojima bi pojednostavio zajedničku distribuciju.

tomekbeli420

Bananaking Ja sam to išao rješavati tako da sam direktno pokušao konstruirati Bayesovu mrežu tako da sam obrnutim postupkom primjenjivao uređajno Markovljevo svojstvo (UMS) nad svakom varijablom:

x_k \perp \operatorname{pred}(x_k) \setminus \operatorname{pa}(x_k) \mid \operatorname{pa}(x_k)

Topološki uređaj je zadan u zadatku, stoga nam je \operatorname{pred}(x_k) poznat za sve varijable.

Npr. \operatorname{pred}(y) = \{v, w, x \}.

Kako?

Pa prvo kreneš od Bayesove mreže koja nema nikakvih uvjetnih nezavisnosti, dakle to je usmjereni aciklički graf sa svim mogućim bridovima, pritom imajući na umu topološki uređaj.

I onda uzmeš ove uvjetne nezavisnosti koje imaš i gledaš onu varijablu koja se pojavljuje sama, odnosno ne u parovima varijabli. Npr. uzmeš ovu prvu uvjetnu nezavisnost \{v, w\} \perp y \mid x

I vidiš da se y pojavljuje sam, i onda što napraviš jest probaš skužiti iz uređajnog Markovljevog svojstva za varijablu y koji su roditelji od y odnosno kakav je \operatorname{pa} (y). Pa čini se da je samo x, što ima smisla jer \operatorname{pred} (y) \setminus \operatorname{pa} (y) ispadne stvarno \{v, w\}, što odgovara onda ovoj uvjetnoj nezavisnosti koja je zadana. Dakle onda pobrišeš bridove vy i wy.

Na istu foru se za drugu uvjetnu nezavisnost zaključi da je \operatorname{pa}(z) = \{w, y\} pa onda samo te bridove koje vode do z sačuvaš (odnosno pobrišeš bridove xz i vz ).

I onda iz dobivene mreže lako iščitaš faktorizaciju:

p (v, w, x, y, z) = p(v) p(w \mid v) p(x \mid v, w) p (y \mid x) p(z \mid w, y)

Distribucija p(v) ima 3-1=2 parametra

Distribucija p(w \mid v) ima 3*(2-1)=3 parametra

Distribucija p(x \mid v, w) ima 3*2*(3-1)=12 parametara

Distribucija p (y \mid x) ima 3*(2-1)=3 parametra

Distribucija p(z \mid w, y) ima 2*2*(2-1)=4 parametra

Sve skupa 24 parametara

Bananaking

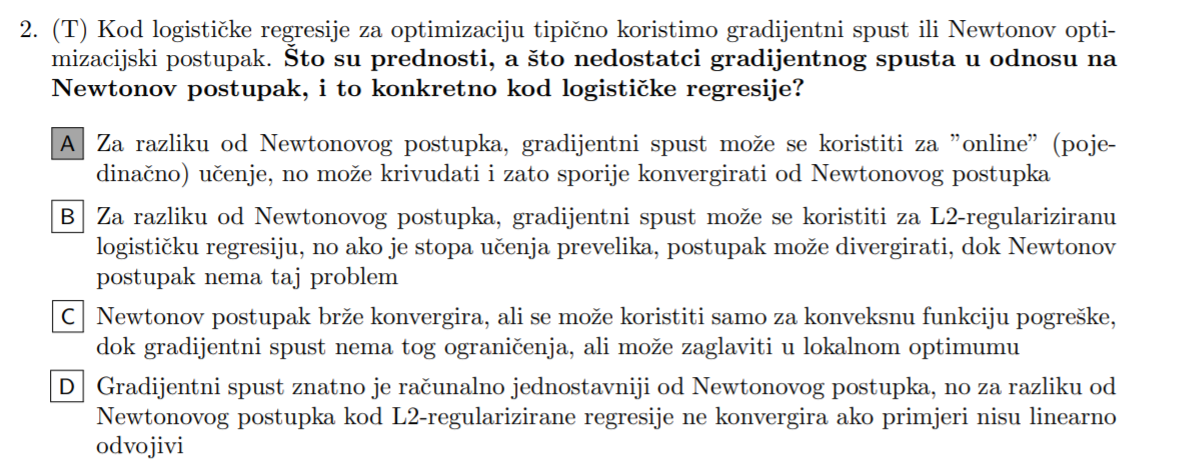

Zašto su B) C) i D) krivi?

sheriffHorsey

Bananaking

b) newtonov postupak moze koristit l2 regularizaciju (skripta, log reg 2, str. 5)

c) ovaj odgovor je otrovan jer ti u pitanju kaze “konkretno kod logisticke regresije” a pise da gradijentni spust moze zaglaviti u lokalnom optimumu sto nije istina jer je funkcija pogreske za logisticku regresiju konveksna i onda te gradijentni spust mora dovesti do globalnog minimuma uz razumnu stopu ucenja

d) u drugom dijelu odgovora kaze “kod l2-regularizirane regresije ne konvergira ako primjeri nisu linearno odvojivi” sto nije istina, sjeti se da logisticka regresije ne konvergira za linearno odvojive primjere ako NE koristis regularizaciju dok u slucaju regularizirane verzije ce povecanje tezina u odredenoj iteraciji povecat vrijednost funkcije pogreske umjesto smanjiti i time doc do konvergencije

micho

sheriffHorsey u b nije krivo što newtonov postupak isto može koristiti l2, nego što će on isto divergirati za preveliku stopu učenja