[STRUCE1] Gradivo

Lujonlu

Ziher ne regulariziras w0, tako da racunas |w| bez w0

Lujonlu

am22 veca preciznost daje slozeniji model. iz skriptice:

Npr., ako odaberemo visoku vrijednost za γ, dobit ćemo složeniji model, pa će trebati pojačati regularizaciju odabirom manje vrijednosti za C.

khm19

Vrba Veci gama daje slozeniji model jer je gama=1/2sigma2, a sto je varijanca manja to je Gaussovo zvono uze pa bi primjeri trebali biti sto blize kako bi bili slicni, a to daje slozeniji model. C takoder s povecanjem daje vecu slozenost jer je c=1/lambda, a sto je lambda manji to je regularizacija manja pa imamo slozeniji model. U zadatku ima 6 C i 6 gama ukljucujuci i C=1 i gama=1, kombinacija je 62=36 i oduzmemo ponuđenu za C=1 i gama=1 i to su preostali prenaučeni modeli.

saitama

cotfuse zasto je skriveni sloj dimenzije 3,a ne 4 ?

cotfuse

saitama Suma koja se direktno vidi u zadatku ide od 0 do 3, a s obzirom da imas bias w0, ostanu ti 3 weighta, sto povlaci da je sirina skrivenog sloja 3

koBASA

johndoe12

Zna li netko tocne odgovore na ova pitanja i objasnjenje?

RogerRoger

Za prvo pitanje, svaka značajka ti je jedan klasifikator. OVO ima K povrh 2 klasifikatora, OVR ima K, gdje je K broj klasa. To znači da u ovom primjeru OVO ima 10 značajki, a OVR 5. Međutim, linearni modeli imaju problem kad su klase neuravnotežene, tj. kad jedna klasa ima puno više primjera od druge, i često ga rješavaju tako da klasificiraju sve ispitne primjere u klasu s više primjera za učenje jer tako minimiziraju empirijsku pogrešku (na štetu manje klase). Za 5 klasa i OVR, omjer primjera za svaki klasifikator je 1:4 i rezultira pogrešnom klasifikacijom primjera “znanosti” (koja je ionako 5x manja od “politike”. Zato je točan odgovor drugi ponuđeni.

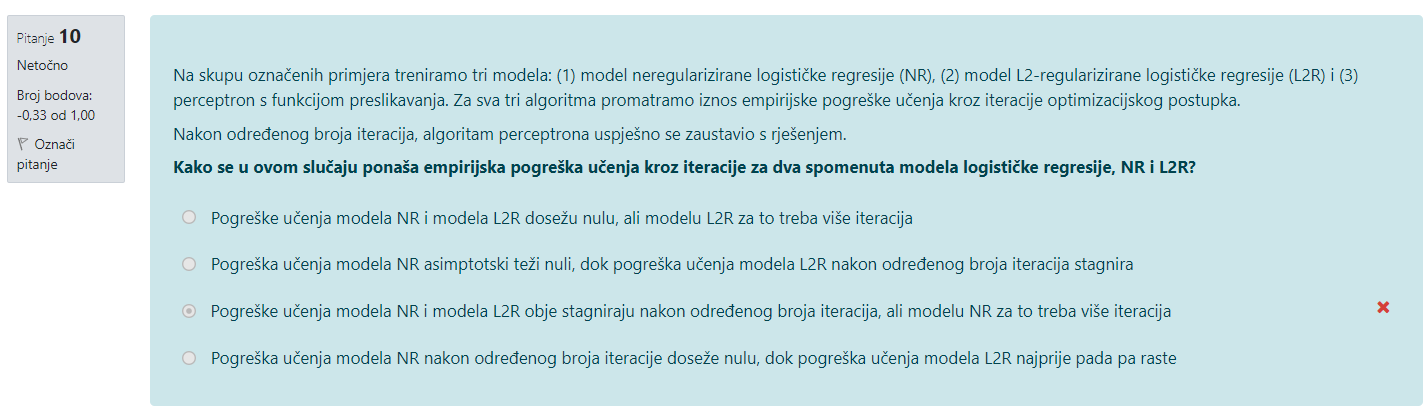

Za drugo pitanje pogledaj onaj graf složenosti modela naspram empirijske pogreške učenja i ispitivanja (iz skriptice Osnovni koncepti). Pogreška učenja asimptotski teži nuli, ali ispitna pogreška pati od prevelike složenosti. Regularizacija smanjuje složenost modela ovisno o magnitudi parametara w, što kao rezultat ima bolju generalizaciju, ali lošiju prilagođenost primjerima za učenje. Za regularizirani model pogreška učenja se smanjuje do određene točke, ali zatim stagnira jer joj regularizacija ne da da teži nuli. Zato je točan odgovor drugi ponuđeni.

Newtonov postupak koristi Hesseovu matricu za čiji je izračun potrebna cijela matrica preslikavanja i zato je neiskoristiv za online učenje. Mora imati sve primjere za učenje odjednom i ne može primati jedan po jedan primjer i podešavati težine, što je moguće stohastičkim gradijentnim spustom. Newtonov je postupak doduše optimizacija drugog reda i uzima u obzir drugu derivaciju funkcije, tj. zakrivljenost plohe čime sprječava krivudanje i zato može brže konvergirati. Opet je točan odgovor drugi ponuđeni.

Stark

hackerman Možeš objasniti kako znamo da je w2 = 0, tj druga težina, ako je prvi član u vektoru alfa 0, a ne drugi?

MJ3

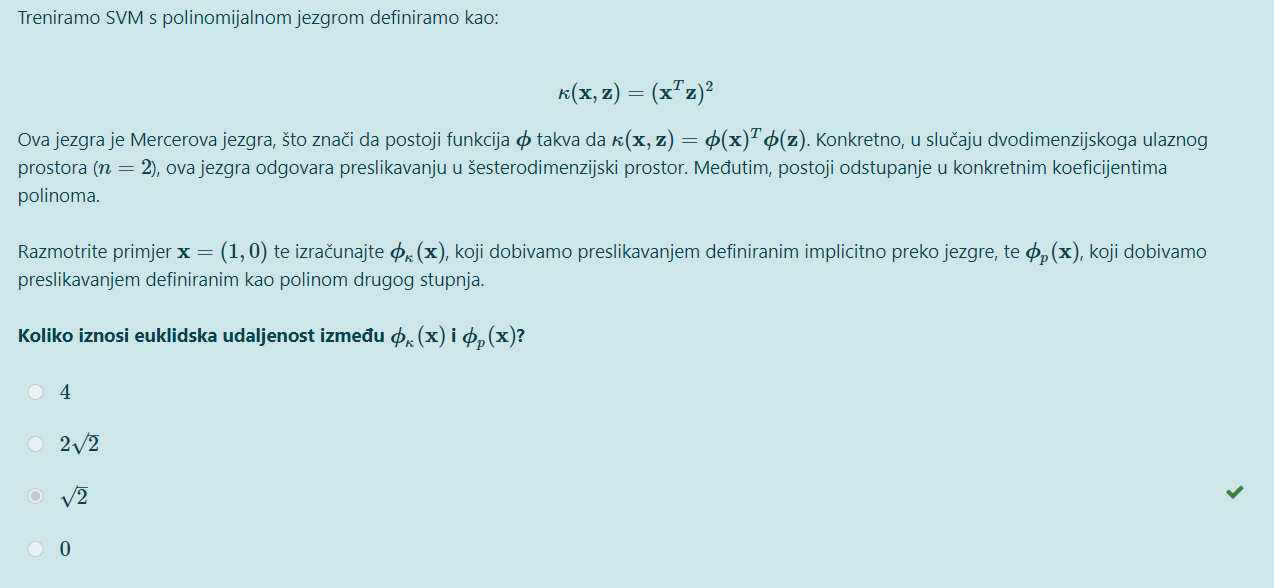

kako izgleda ulaz x nakon preslikavanja polinomom 2.stupnja?

[obrisani korisnik]

MJ3 1 + x_1 + x_2 + x_1x_2 + x_1^2 + x_2^2

https://fer.studosi.net/d/1348-struce-pitanja-i-odgovori/73

johndoe12

gdje se moze naci objasnjene o induckijskoj pristranosti, u skripti na webu ne vidim..

InCogNiTo124

stateboli

InCogNiTo124 Treci zadatak, 23 je rješenje promijenili su zadatak

Yeltneb

Stark

Nije nitko odgovorio pa ponavljam, jel zna netko ovo objasniti?

cotfuse

Yeltneb Stark

ako skup podataka nije linearno odvojiv to znaci da kakav god pravac (pravac odluke modela perceptrona) provuces kroz te podatke, barem jedan primjer ce biti s krive strane pravca. Ti primjeri s krive strane pravca ce uzrokovati da je gradijent gubtka veci od 0 i zbog toga ce se pravac stalno micati kako bi pokusao uhvatiti te preostale primjere, odnosno model nece konvergirati.

Atem

cotfuse Na temelju čega si zaključio da će gradijent u svakom primjeru biti veći od nule? Zato što svaki par (x,y) ima barem jednu nulu u sebi?

SuperSjajan3

cotfuse

Atem ne znam sto znaci da svaki par x,y ima barem jednu nulu u sebi

Meni je to najlakse onak intuitivno poznavajuci onaj graf prostora funkcije gubtka perceptrona koji mozes naci na dnu stranice 15 skriptice o linearnim diskriminativnim modelima. Tamo mozes vidjeti da je nagib grafa konstantan na segmentima. Svaki taj segment predstavlja prostor parametara gdje model jednak broj primjera netocno klasificira. Gdje vise grijesimo, taj je segment strmiji. Ti svi segmenti gradijentnim spustom vode u jedan segment koji je ravan, gdje je gradijent 0. To je prostor gdje model perceptrona sve primjere dobro klasificira. Sad, kad znamo da prostor nije linearno odvojiv, kako nam se mijenja taj graf? Pa znamo da ne mozemo sve primjere tocno klasificirati pa ce taj graf uvijek imati neki nagib, aka gradijent ce uvijek biti veci od 0. Nas postupak optimizacije ce zapravo stalno plesati oko nekog sjecista dva segmenta.

hi_doggy

Može netko objasnit? Hvala

Ziher

hi_doggy Znaci imamo 2 slucaja: alpha je 0 (promatrani vektor nije potporni) i alpha >0 (promatrani vektor je potporni), sto znaci da izraz u drugoj zagradi mora biti jednak 0 da bi jednakost vrijedila. Taj drugi izraz znaci da se promatrani vektor nalazi na margini (ksi je 0) ili unutar nje (ksi je veci od 0). S obzirom kako ksi ne moze biti < 0, potporni vektori nikad nece izaci izvan margine s prave strane granice.

Sto se tice drugog pitanja, zapises si tu razliku u odnosu na rijec “straja” i onda gledas koji su ti primjeri najblizi (konkretno, 3 clana za koji imas najmanji L) i onda ih prebrojis i napravis glasanje (2 jedinice + 1 nula = klasa 1). Onda, samo sto trebas je uvrstiti to sto si dobio u ovu jezgru i gledas najvece brojeve koje si dobio (jer je slicnost veca) i opet dobijes 1. Znaci h1=h2=1

koBASA

Stark

w2 bi ti bilo -1*0*3 + (-1)*0.01*4 + 1*0.01*4 pa je to nula, nema to veze s tim da je prvi član vektora alfa 0, to ti samo znači da ne gledaš vektor koji nije potporni jer ga 0 poništi.